Развитие информационных технологий. Перспективы развития поисковых систем

Во времена, когда только начиналось развитие интернета, объём доступной информации был сравнительно мал, и пользователей сети было немного. На начальных стадиях развития сети, ее использовали сотрудники университетов и исследовательских лабораторий для обмена информацией между учреждениями. В то время поиск информации в сети интернет был не актуальным, в отличие от нынешних дней.

Первым способом организации и систематизации доступа к информационным ресурсам стало создание каталогов сайтов. В них стали группировать ссылки согласно определенной тематике.

Первопроходцем области стал Yahoo, который появился в апреле 1994 года. С течением времени количество сайтов возрастало, и Yahoo добавил опцию поиска по каталогам. Это не была поисковая система в прямом смысле, потому что область поиска ограничивалась ресурсами каталога.

Впоследствии каталоги распространились и стали использоваться повсеместно, но и интернет не стоял на месте, а продолжал развиваться. Вместе с ним развивались и методы поиска. На данный момент каталоги почти утратили популярность, это объясняется тем, что современный каталог, даже если он содержит огромное количество ресурсов, сможет обеспечить доступ лишь к малой части информации, которая содержится в сети.

В наши дни самым большим каталогом сети является Open Directory Project или DMOZ, включающий в себя информацию о 5 миллионах ресурсов, но это относительно мало, если сравнивать его, например, с поисковой системой Google, которая содержит около 8 миллиардов документов.

Полноценная же поисковая система вышла в свет только в 1994 году, ей стала система поиска WebCrawler.

Год спустя, в 1995 году появились проекты поисковых систем AltaVista и Lycos. Одна из них, в частности AltaVista, удерживала лидирующие позиции в области поиска в течение долгих лет.

По прошествии двух лет, в 1997 году, студенты Стэндфордского университета Сергей Брин и Ларри Пейдж разработали поисковую систему Google, являющуюся лидером в области поиска на сегодняшний день.

Этот год так же стал годом, когда было официально анонсировано о создании Российской поисковой системы Яндекс, которая и ныне лидирует в русскоязычном сегменте сети.

На данный момент существует только 3 поисковые системы, которые вышли на международный уровень, это MSN Search, Yahoo и Google. Эти системы имеют свои базы и поисковые алгоритмы. Большая часть остальных поисковиков используют их результаты. Так Mail.ru использует базу Yandex , search.aol.com — Google, а Lycos, AltaVista и AllTheWeb — Yahoo.

Лидером поиска на русских просторах интернета на данный момент является Яндекс, за ним — Rambler, далее идут Google, Mail.ru, A port и KM.ru.

У поисковых систем разные алгоритмы работы, и чтобы занять хорошую позицию в поисковой выдаче и привлечь целевых посетителей, нужно знать особенности SEO оптимизации для разных поисковиков. Например

Алгоритмы ранжирования поисковых систем постоянно развиваются и совершенствуются. Главные цели этого развития - обеспечение высокого качества поиска для пользователей и создание максимальных трудностей для манипулирования поисковой выдачей оптимизаторами сайтов.

Данные цели взаимосвязаны, так как качество поиска напрямую зависит от возможности или невозможности повлиять на него заинтересованным лицам.

Когда поисковые системы Яндекс и Google только начинали свое развитие, их алгоритмы ранжирования были примитивны, что позволяло довольно просто манипулировать ими.

В те далекие времена на релевантность страницы оказывали высокое влияние:

- мета-теги ;

- плотность ключевых слов на странице;

- теги выделения.

Это была золотая пора для дорвейщиков всех разновидностей, которым не составляло никакого труда добывать килотонны целевого трафика без особых усилий, ухудшая при этом общее качество поиска.

В результате, поисковые системы перестали учитывать мета-тег Keywords и, по всей видимости - Description, который теперь используется лишь для формирования сниппета в Google. Так же снизилась значимость других факторов внутренней оптимизации, которые позволяли злостно манипулировать поисковой выдачей.

Затем оптимизаторами было установлено, что количество внешних ссылок на сайт, а так же их анкоры влияют на позиции сайта в результатах поиска. Сразу же появились тысячи каталогов сайтов и программы автоматического добавления в них (самая известная программа такого рода - AllSubmitter).

Это были золотые времена для спамеров. Поисковые системы довольно быстро забанили большую часть каталогов сайтов, резко понизив эффективность прогонов по каталогам, которые стали массово использоваться оптимизаторами.

После этого эффективные попытки манипулирования поисковой выдачей стали, главным образом, заключаться в покупке ссылок с обычных сайтов, созданных не на каталожных скриптах.

Это были золотые времена сателлитчиков. Очень скоро поисковые системы научились распознавать грубую работу по продаже ссылок и ввели санкции в виде фильтра или бана для сайтов, созданных исключительно для продажи ссылок. Причем в некоторых случаях санкции могут касаться сайтов, на которые ссылки закупаются.

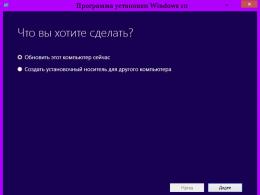

Все этапы развития поисковых систем представляют собой следующую логическую цепочку:

1. Создается некоторый базовый алгоритм ранжирования.

2. Оптимизаторы выявляют в нем слабые места и начинают массово манипулировать поисковой выдачей.

3. Поисковые системы серьезно корректируют алгоритм ранжирования, изменяя степень влияния тех или иных факторов.

4. Оптимизаторы анализируют эти изменения, приспосабливаются к новым условиям и вновь начинают массово манипулировать поиском.

Однако эта игра все же когда-нибудь закончится. Дело в том, что алгоритмы ранжирования поисковых систем в последнее время не только меняют значимость различных факторов, но и изменяются качественно вообще.

Мало того, что актуальным становится комплексный учет сотен различных факторов, так ещё упраздняется единая формула ранжирования, вместо которой начинает использоваться матричная система. Пример тому - алгоритм Яндекса «Снежинск» .

По новой системе, для каждого отдельного запроса генерируется своя формула ранжирования, которая может быть совершенно не похожа на формулу ранжирования по другим запросам. Если раньше можно было довольно просто выявить какие-то общие зависимости в принципах ранжирования поисковой системы, то в дальнейшем общих зависимостей просто не будет.

Платные инструменты для продвижения сайтов скорее всего останутся, но их использование с большой вероятностью станет экономически нецелесообразно. Именно такая ситуация наблюдается сейчас в англоязычном секторе интернета.

В недалеком будущем для продвижения сайта наибольший эффект будет оказывать совокупность следующих основных факторов:

Большой массив качественного контента (уникального и полезного);

- траст сайта;

- возраст сайта;

- разумная внутренняя оптимизация.

Какое-то особое техническое продвижение, основанное на выявлении слабых мест в алгоритмах ранжирования, скорее всего, потеряет актуальность. По крайней мере, все к этому идет.

Статьи по теме .

Современные поисковые системы — это мощнейшие аппаратно-программные комплексы, целью которых является индексирование документов в сети интернет для выдачи данных по запросу пользователей.

Для предоставления качественной и актуальной информации поисковым системам приходится постоянно совершенствовать свои формулы ранжирования. Обеспечение максимально высокого качества выдачи для пользователей и воспрепятствование манипуляциям с ней со стороны оптимизаторов — вот ключевые цели развития поисковых систем.

Во времена, когда поисковые системы только-только стали появляться на свет, их алгоритмы ранжирования были очень примитивны. Благодаря чему наиболее находчивые оптимизаторы стали продвигать свои сайты так, чтобы они появлялись в выдаче по интересующим их запросам. В результате это привело к тому, что ресурсы, которые зачастую не несли пользователю никакой полезной информации, становились первыми, тем самым отодвигая более полезные сайты на второй план.

В ответ на эти действия поисковые системы стали защищаться, совершенствуя свои алгоритмы ранжирования, вводя в формулы все новые переменные и учитывая все новые факторы. Со временем эта борьба оптимизаторов и поисковых систем перешла на новый уровень и поспособствовала появлению более совершенных алгоритмов, основанных, в том числе и на машинном обучении.

Этапы развития поисковых систем:

Как можно увидеть из схемы, развитие поисковых систем и их алгоритмов идет по кругу. Одни создают новые алгоритмы, другие приспосабливаются к ним. Сложно сказать, остановится ли когда-нибудь этот процесс, но лично я склонен считать, что нет. Несмотря на то, что алгоритмы ранжирования поисковых систем в последнее время не только меняют значимость различных факторов, но и изменяются качественно, это не пугает оптимизаторов: их арсенал постоянно пополняется все более новыми приемами.

Как часто поисковые системы изменяют свои алгоритмы?

Обратимся к главной поисковой системе Рунета — Яндексу. Качественные и принципиальные изменения формул ранжирования в ней происходят в среднем один раз в год. Не так давно Яндекс представил новую поисковую платформу под названием “Калининград”. Ее суть состоит в формировании персональной выдачи для каждого пользователя на основании его поисковой истории и предпочтений.

Помимо этого не стоит забывать, что у каждой поисковой системы, в том числе и у Яндекса, постоянно случаются “подкрутки” формул ранжирования, когда в автоматическом либо полуавтоматическом режиме влияние определенных факторов занижается, а других, наоборот, — повышается. Все это делается лишь с одной целью — максимально улучшить поисковую выдачу, избавив её от сайтов, не удовлетворяющих потребности пользователей, и тем самым повысить её релевантность.

Рассматривая изменения в поисковой системе Google, можно увидеть, что преобразования формулы ранжирования также происходят постоянно, а сам Google из года в год рапортует о сотнях мелких изменений. Но если говорить не о формуле ранжирования, а о фильтрах, которые помогают Google очищать выдачу от низкокачественных сайтов, то новые версии алгоритмов, такие как Панда или Пингвин, появляются с периодичностью раз в 3-6 месяцев.

Ответить на поставленный выше вопрос можно так: поисковые системы постоянно совершенствуют алгоритмы ранжирования, а кардинальные изменения происходят в среднем раз в 6-12 месяцев.

Какие алгоритмы поисковых систем представляют реальную угрозу для продвижения?

Хочется ответить “слёту” — никакие, но все же давайте разберемся. А для этого нам надо задаться вопросом — ставят ли поисковые системы своей целью воспрепятствовать поисковому продвижению?

Я считаю, что нет. Для этого есть несколько обоснований:

1. Оптимизаторы помогают поисковым системам совершенствовать свои алгоритмы, что в конечном счете приводит к улучшению качества выдачи. Ведь если бы не было оптимизаторов, то и поисковые системы, вероятнее всего, остановились бы в своем развитии в 2000-м году.

2. Без оптимизаторов выдача по многим коммерческим запросам была бы похожа на сборник рефератов и бесполезных информационных статей.

Если бы поискового продвижения не существовало в принципе, то и поисковым системам не имело бы смысла расти и развиваться так же интенсивно, как они делают это сейчас.

Таким образом, мы приходим к следующему выводу:

Поисковые системы и SEO тесно и неразрывно связаны друг с другом. Именно поэтому, соблюдая установленные ими правила, можно абсолютно не бояться алгоритмов, ведь ПС не ставят своей целью уничтожить SEO как таковое.

Развитие сервисов поисковых систем

Говоря о поисковых системах, не стоит забывать о том, что у Яндекс, Google или Bing существуют собственные сервисы, призванные помочь пользователям. Помимо поисковых результатов, за годы эволюции ПС изучили поведение своих пользователей с целью повысить удовлетворенность результатами выдачи.

Собственно для этого поисковая система Яндекс и придумала механизм т.н. “Колдунщиков”, которые помогают пользователю быстро получить ответ на свой вопрос. Так, например, при вводе запроса «прогноз погоды» Яндекс прямо на странице с результатами поиска отобразит информацию о погоде на текущую дату, избавив тем самым пользователя от необходимости переходить по результатам выдачи.

Другие поисковые системы, например, Google, пошли дальше и вместо “Колдунщиков” предложили более интересное решение — “Граф знаний”.

“Граф знаний” (с англ. Knowledge Graph) — это первая ступень на пути Google к интеллектуальному поиску. Благодаря этому нововведению поисковик отображает в результатах выдачи не только стандартные ссылки, но и прямые ответы на вопросы пользователей, краткую справку об объекте запроса и информацию о связанных с ним фактах. Технически “Граф знаний” представляет собой семантическую сеть, связывающую воедино различные сущности: личности, события, сферы жизни, вещи, категории. Информационной базой для “графа знаний” служит целый ряд источников: открытая семантическая база данных Freebase, Википедия, сборник открытых данных ЦРУ и прочие источники.

Какие выводы можно сделать, спросите вы?

Ответ прост: поиск и поисковые сервисы и дальше будут развиваться в сторону быстрых и актуальных ответов на вопросы пользователей, предоставляя возможность получить всю необходимую информацию прямо в SERP (выдачу) и избавляя от необходимости переходить на другие сайты.

Существует мнение, что поисковые системы своим стремлением ответить на вопрос пользователя здесь и сейчас могут уничтожить поисковую оптимизацию, став этакими глобальными базами знаний. Но такие опасения беспочвенны, поскольку для того, чтобы стать глобальными базами знаний, им нужна информация, а её хранят те самые сайты, над которыми работают те самые оптимизаторы, которые причастны к тому, что поисковые системы не стоят на месте, а постоянно эволюционируют.

Как видно, и SEO, и поисковые системы — звенья одной цепи, которые не могут существовать друг без друга. Поэтому мысли о скорой смерти SEO безосновательны. Вполне возможно, что поисковая оптимизация со временем эволюционирует, к примеру, в консалтинг, но уж точно не умрет. Желаю всем удачного продвижения в ТОП!

Задаваемый булевыми операторами поиск является буквальным – машина осуществляет поиск слов или фраз точно в таком виде, в каком их ввели. Это может порождать проблемы, когда введенные слова многозначны. Например, английское слово «Bed» может означать кровать, клумбу, место, где рыба мечет икру, и многое другое. Если пользователя интересует только одно из этих значений, ему не нужны страницы со словом, имеющим другие значения. Можно построить буквальный поисковый запрос, нацеленный на отсечение нежелательных значений, но было бы неплохо, если бы сама поисковая машина могла оказывать соответствующую помощь.

Один из вариантов работы поисковой машины – концептуальный поиск. Часть такого поиска предусматривает использование статистического анализа страниц, содержащих введенные пользователем слова или фразы, для нахождения других страниц, которые могли бы этого пользователя заинтересовать. Понятно, что для концептуального поиска требуется хранить больше информации о каждой странице, и каждый поисковый запрос потребует большего числа вычислений. В настоящее время многие группы разработчиков занимаются повышением результативности и производительности поисковых машин такого типа. Другие исследователи сфокусировались на иной области, которую именуют естественно-языковыми запросами (natural-languagequeries).

Идея естественно-языковых запросов состоит в том, чтобы пользователь формулировал запрос так же, как он бы спрашивал у человека, сидящего рядом – при этом не нужно отслеживать булевы операторы или сложные структуры запросов. Наиболее популярным современным сайтом с естественно-языковыми поисковыми запросами является AskJeeves.com, анализирующий запрос с целью выявления ключевых слов, которые затем используются для поиска в построенном этой поисковой машиной указателе сайтов. Упомянутый сайт работает только с простыми поисковыми запросами, однако разработчики в условиях жесткой конкуренции занимаются разработкой машины с естественно-языковыми поисковыми запросами, способной обрабатывать очень сложные запросы.

30. Семантические системы: определение, назначение, техническая суть, классификация, характеристики, архитектура, примеры и перспективы развития. Основные принципы оптимизации семантической сети

Семантическая сеть (система) – информационная модель предметной области, имеющая вид ориентированного графа, вершины которого соответствуют объектам предметной области, а дуги (рёбра) задают отношения между ними. Объектами могут быть понятия, события, свойства, процессы. Таким образом, семантическая сеть является одним из способов представления знаний. В названии соединены термины из двух наук: семантика в языкознании изучает смысл единиц языка, а сеть в математике представляет собой разновидность графа – набора вершин, соединённых дугами (рёбрами). В семантической сети роль вершин выполняют понятия базы знаний, а дуги (причем направленные) задают отношения между ними. Таким образом, семантическая сеть отражает семантику предметной области в виде понятий и отношений.

Математика позволяет описать большинство явлений в окружающем мире в виде логических высказываний. Семантические сети возникли как попытка визуализации математических формул. Основным представлением для семантической сети является граф . Однако не стоит забывать, что за графическим изображением непременно стоит строгая математическая запись, и что обе эти формы являются не конкурирующими, а взаимодополняющими.

Основной формой представления семантической сети является граф. Понятия семантической сети записываются в овалах или прямоугольниках и соединяются стрелками с подписями - дугами (см. рис.). Это наиболее удобно воспринимаемая человеком форма. Её недостатки проявляются, когда мы начинаем строить более сложные сети или пытаемся учесть особенности естественного языка. Схемы семантических сетей, на которых указаны направления навигационных отношений, называют картами знаний, а их совокупность, позволяющая охватить большие участки семантической сети, атласом знания.

В математике граф представляется множеством вершин V и множеством отношений между ними E. Используя аппарат математической логики, приходим к выводу, что каждая вершина соответствует элементу предметного множества, а дуга – предикату.

Пример семантической сети (системы)

В лингвистике отношения фиксируются в словарях и в тезаурусах. В словарях в определениях через род и видовое отличие родовое понятие занимает определённое место. В тезаурусах в статье каждого термина могут быть указаны все возможные его связи с другими родственными по теме терминами. От таких тезаурусов необходимо отличать тезаурусы информационно- поисковые с перечнями ключевых слов в статьях, которые предназначены для работы дескрипторных поисковых систем.

Классификация семантических сетей

Для всех семантических сетей справедливо разделение по арности и количеству типов отношений.

· По количеству типов отношений, сети могут быть однородными и неоднородными .

o Однородные сети обладают только одним типом отношений (стрелок), например, таковой является вышеупомянутая классификация биологических видов (с единственным отношением AKO).

o В неоднородных сетях количество типов отношений больше двух. Классические иллюстрации данной модели представления знаний представляют именно такие сети. Неоднородные сети представляют больший интерес для практических целей, но и большую сложность для исследования. Неоднородные сети можно представлять как переплетение древовидных многослойных структур. Примером такой сети может быть Семантическая сеть Википедии.

· По арности:

o типичными являются сети с бинарными отношениями (связывающими ровно два понятия). Бинарные отношения очень просты и удобно изображаются на графе в виде стрелки между двух концептов. Кроме того, они играют исключительную роль в математике.

o На практике, однако, могут понадобиться отношения, связывающие более двух объектов – N-арные . При этом возникает сложность – как изобразить подобную связь на графе, чтобы не запутаться. Концептуальные графы (см. ниже) снимают это затруднение, представляя каждое отношение в виде отдельного узла.

· По размеру:

o Для решения конкретных задач, например, тех которые решают системы искусственного интеллекта.

o С. С. отраслевого масштаба должна служить базой для создания конкретных систем, не претендуя на всеобщее значение.

o Глобальная семантическая сеть. Теоретически такая сеть должна существовать, поскольку всё в мире взаимосвязано. Возможно, когда-нибудь такой сетью станет Всемирная паутина.

Использование семантических сетей

Семантизация - процесс изменения текстов, в которых выделяются семантические отношения без изменения их содержания. В Википедии существуют проекты по семантизации статей и Дерева категорий.

§ Семантизация статей заключается в основном путём использования шаблонов, при этом некоторые категории создаются автоматически.

§ Семантизация Дерева категорий возможна по частям после его анализа и выделения участков с родовыми категориями

Семантическая паутина

Концепция организации гипертекста напоминает однородную бинарную семантическую сеть, однако здесь есть существенное отличие:

1. Связь, осуществляемая гиперссылкой, не имеет семантики, т.е. не описывает смысла этой связи. Назначение семантической сети состоит в том, чтобы описать взаимосвязи объектов, а не дополнительную информацию по предметной области. Человек может разобраться, зачем нужна та или иная гиперссылка, но компьютеру эта связь не понятна.

2. Страницы, связываемые гиперссылками, являются документами , описывающими, как правило, проблемную ситуацию в целом. В семантической сети вершины (то, что связывают отношения) представляют собой понятия или объекты реального мира .

Попытка создания семантической сети на основе Всемирной паутины получила название семантической паутины . Эта концепция подразумевает использование языка RDF(языка разметки на основе XML) и призвана придать ссылкам некий смысл, понятный компьютерным системам. Это позволит превратить Интернет в распределённую базу знаний глобального масштаба.