Utwórz plik txt robotów wordpress. Prawidłowa konfiguracja wtyczki WooCommerce

Cześć wszystkim! Dziś artykuł o tym, jak powinno być poprawny plik robots.txt dla WordPressa. Funkcje i cel ustaliliśmy kilka dni temu, a teraz przeanalizujemy konkretny przykład dla Wordpressa.

Za pomocą tego pliku mamy możliwość ustalenia podstawowych reguł indeksowania dla różnych wyszukiwarek, a także nadawania praw dostępu dla poszczególnych robotów wyszukujących. Na przykładzie przeanalizuję, jak komponować poprawny plik robots.txt dla WordPressa. Za podstawę wezmę dwie główne. Wyszukiwarki- Yandex i Google.

W wąskich kręgach webmasterów można spotkać się z opinią, że konieczne jest stworzenie osobnej sekcji dla Yandex, odwołującej się do niej poprzez User-agent: Yandex. Zastanówmy się razem, na czym opierają się te przekonania.

Yandex wspiera dyrektywy Clean-param oraz Gospodarz o których Google nic nie wie i nie używa podczas indeksowania.

Rozsądnie jest używać ich tylko dla Yandex, ale jest niuans - są to dyrektywy przecinające się, które można umieścić w dowolnym miejscu w pliku, a Google po prostu ich nie weźmie pod uwagę. W takim przypadku, jeśli reguły indeksowania są takie same dla obu wyszukiwarek, wystarczy użyć User-agent: * dla wszystkich robotów wyszukiwania.

Uzyskując dostęp do robotów przez User-agent, należy pamiętać, że plik jest odczytywany i przetwarzany od góry do dołu, dlatego korzystając z User-agent: Yandex lub User-agent: Googlebot, musisz umieścić te sekcje na początku plik.

Przykład robots.txt dla WordPress

Chcę Cię od razu ostrzec: nie ma idealnego pliku, który byłby odpowiedni dla absolutnie wszystkich witryn działających na Wordpress! Nie podążaj za tropem, kopiując na ślepo zawartość akt bez analizy pod kątem konkretnego przypadku! Wiele zależy od wybranych ustawień linków bezpośrednich, struktury witryny, a nawet zainstalowane wtyczki... Rozważam przykład, w którym używane są CNC i permalinki, takie jak /% postname% /.

Jak każdy system zarządzania treścią posiada własne zasoby administracyjne, katalogi administracyjne itd., których nie należy umieszczać w indeksie wyszukiwarek. Aby chronić takie strony przed dostępem, musisz zabronić ich indeksowania w tym pliku za pomocą następujących wierszy:

Disallow: / cgi-bin Disallow: / wp-

Dyrektywa w drugiej linii zamknie dostęp do wszystkich katalogów zaczynających się od /wp-, które obejmują:

- wp-admin

- wp-treść

- wp-zawiera

Ale wiemy, że domyślne obrazy są ładowane do folderu przesyłanie który jest w katalogu wp-treść... Włączmy ich indeksowanie za pomocą ciągu:

Pozwalać na: * / przesłanePliki usługi zostały zamknięte, przystępujemy do wykluczania duplikatów z główną treścią, które zmniejszają się w obrębie jednej domeny i zwiększają prawdopodobieństwo nałożenia filtra na stronę przez PS. Duplikaty obejmują strony kategorii, autorów, tagów, kanałów RSS, a także nawigację po stronach, trackbacki i strony z indywidualnymi komentarzami. Pamiętaj, aby zabronić ich indeksowania:

Disallow: / kategoria / Disallow: / autor / Disallow: / strona / Disallow: / tag / Disallow: * / feed / Disallow: * / trackback Disallow: * / komentarze

Ponadto chciałbym zwrócić szczególną uwagę na taki aspekt jak. Jeśli używasz CNC, to strony zawierające znaki zapytania w adresie URL są często „zbędne” i ponownie powielają główną treść. Takie strony z parametrami powinny być zabronione w ten sam sposób:

Uniemożliwić: * /?

Ta zasada dotyczy prostych permalinków ?P=1, stron z zapytaniami?S= i innych parametrów. Kolejnym problemem mogą być strony archiwów zawierające rok, miesiąc w adresie URL. W rzeczywistości bardzo łatwo jest je zamknąć za pomocą maski 20 *, uniemożliwiając w ten sposób indeksowanie archiwów według roku:

Odrzuć: / 20 *

Aby przyspieszyć i zakończyć indeksowanie, dodajmy ścieżkę do lokalizacji. Robot przetworzy plik i przy następnej wizycie na stronie użyje go do priorytetowego indeksowania stron.

Mapa strony: https: //site/sitemap.xml

W pliku robots.txt możesz umieścić dodatkowe informacje dla robotów, aby poprawić jakość indeksowania. Wśród nich dyrektywa Host - wskazuje na Yandex:

Host: webliberty .ruGdy witryna działa przez HTTPS, musisz określić protokół:

Host: https://witryna

20 marca 2018 r. Yandex oficjalnie przestał wspierać dyrektywę Host. Można go usunąć z pliku robots.txt, a jeśli go zostawisz, robot po prostu go zignoruje.

Podsumowując, poskładałem wszystko w całość i uzyskałem zawartość pliku robots.txt dla WordPressa, z którego korzystam od kilku lat, a jednocześnie w indeksie nie ma duplikatów:

User-agent: * Disallow: / cgi-bin Disallow: / wp- Disallow: / kategoria / Disallow: / autor / Disallow: / strona / Disallow: / tag / Disallow: * / feed / Disallow: / 20 * Disallow: * / trackback Disallow: * / komentarze Disallow: * /? Zezwól: * / przesyłanie Mapa strony: https: //site/sitemap.xml

Stale monitoruj postęp indeksowania i popraw plik na czas, jeśli pojawią się duplikaty.

Wiele zależy od tego, czy plik jest skompilowany poprawnie, czy nie, dlatego zwróć szczególną uwagę na jego kompilację, aby wyszukiwarki szybko i sprawnie zaindeksowały witrynę. Jeśli masz jakieś pytania - pytaj, chętnie odpowiem!

Witajcie drodzy czytelnicy! Z tobą projekt "Anatomia Biznesu" i webmaster Alexander. Kontynuujemy serię artykułów podręcznika „Jak stworzyć stronę internetową na WordPressie i zarabiać na niej”, a dziś porozmawiamy o tym, jak utworzyć plik robots.txt dla WordPress i dlaczego potrzebujesz tego pliku.

W ciągu ostatnich 16 lekcji omówiliśmy ogromną ilość materiału. Nasza strona jest już prawie gotowa, aby zacząć wypełniać ją ciekawą treścią i optymalizacją SEO.

Więc przejdźmy do rzeczy!

Dlaczego witryna potrzebuje pliku robots.txt?

Główną wartością na naszej stronie będzie treść, ale oprócz niej strona zawiera całą masę sekcji technicznych lub stron, które nie są czymś wartościowym dla robota wyszukiwania.

Te sekcje obejmują:

- Administrator. płyta

- Szukaj

- możesz chcieć zamknąć komentarze z indeksowania

- lub kilka zduplikowanych stron, które mają te same znaki w adresach URL

Ogólnie rzecz biorąc, plik robots.txt ma na celu uniemożliwienie robotowi wyszukiwania indeksowania niektórych stron.

Kiedyś to zdjęcie bardzo mi pomogło w zrozumieniu, jak działa robots txt:

Jak widzimy, po pierwsze, kiedy robot wyszukiwania wchodzi na stronę, szuka właśnie tego konkretnego Pliku! Po jego przeanalizowaniu rozumie, do których katalogów musi się udać, a do których nie.

Wielu początkujących webmasterów zaniedbuje ten plik, ale na próżno! Ponieważ indeksowanie Twojej witryny zależy od jej pozycji w wyszukiwarce.

Przykład napisania pliku robots.txt dla WordPress

Zastanówmy się teraz, jak napisać ten plik. Nie ma tu nic skomplikowanego, żeby to napisać wystarczy otworzyć zwykłe Edytor tekstu„Notatnik” lub możesz skorzystać z profesjonalnego edytora, takiego jak notatnik +.

Wprowadź do edytora następujące dane:

Klient użytkownika: Yandex

Disallow: / wp-admin

Disallow: / wp-zawiera

Disallow: / wp-komentarze

Disallow: / wp-content / motywy

Zabroń: /wp-login.php

Zabroń: /wp-register.php

Nie zezwalaj: * / śledzenie

Nie zezwalaj: * / pasza

Odrzuć: / cgi-bin

Nie zezwalaj: *? S =

Host: site.ruAgent użytkownika: *

Disallow: / wp-admin

Disallow: / wp-zawiera

Disallow: / wp-komentarze

Disallow: / wp-content / wtyczki

Disallow: / wp-content / motywy

Zabroń: /wp-login.php

Zabroń: /wp-register.php

Nie zezwalaj: * / śledzenie

Nie zezwalaj: * / pasza

Odrzuć: / cgi-bin

Nie zezwalaj: *? S =Mapa witryny: http://site.ru/sitemap.xml

Teraz zajmijmy się tym wszystkim.

Pierwszą rzeczą, którą należy zauważyć, jest to, że plik jest podzielony na dwa duże bloki.

A na początku każdego bloku znajduje się katalog „User-agent”, który wskazuje, dla którego robota został wykonany ten blok.

Nasz pierwszy blok powstał dla robotów Yandex, o czym świadczą podany ciąg: „Agent użytkownika: Yandex”

Drugi blok mówi, że dotyczy wszystkich innych robotów. Jest to oznaczone gwiazdką „Agent użytkownika: *”.

Katalog „Disallow” określa, które sekcje nie mogą być indeksowane.

Teraz spójrzmy na sekcje:

/ wp-admin- zakaz indeksowania admin. panele

/ wp-zawiera- zakaz indeksowania foldery systemowe Silnik WordPress

/ wp-komentarze- zakaz indeksowania komentarzy

/ wp-content / wtyczki- zakaz indeksowania folderu z wtyczkami do WordPress

/ wp-content / motywy- zakaz indeksowania folderu z motywami dla WordPress

/wp-login.php- zakaz indeksowania formularza logowania w serwisie

/wp-register.php- zamknij formularz rejestracyjny z robota

* / karmić- zakaz indeksowania kanału RSS bloga

/ cgi-bin- zakaz indeksowania katalogu skryptów na serwerze

*?s =- zakaz indeksowania wszystkich adresów URL, które zawierają?S =

A na samym końcu robots.txt pokazujemy robota, w którym znajduje się plik sitemap.xml

Mapa witryny: http://site.ru/sitemap.xml

Gdy plik jest gotowy, zapisujemy go w katalogu głównym witryny.

Jak zamknąć niektóre kategorie z indeksowania?

Na przykład nie chcesz pokazywać jakiejś kategorii w swojej witrynie dla robotów wyszukiwania. Powody tego mogą być zupełnie inne. Na przykład chcesz, aby Pamiętnik czytane tylko przez zwykłych odwiedzających witrynę.

Pierwszą rzeczą, którą musimy zrobić, to znaleźć adres URL dla tej kategorii. Najprawdopodobniej będzie to / moy-dnevnik.

Aby zamknąć ten nagłówek, wystarczy dodać do niego następujący wiersz: Disallow: / moy-dnevnik

Robots.txt - kiedy czekać na efekt?

Z własnego doświadczenia mogę powiedzieć, że nie należy oczekiwać, że przy następnej aktualizacji wszystkie zamknięte sekcje zostaną usunięte z indeksu. Czasami ten proces może potrwać do dwóch miesięcy. Tylko bądź cierpliwy.

Należy również pamiętać, że roboty Google mogą po prostu zignorować ten plik, jeśli uznają, że strona jest bardzo unikalna i interesująca.

O czym ZAWSZE należy pamiętać!

Oczywiście komponent techniczny nie jest bez znaczenia, ale przede wszystkim trzeba skupić się na użytecznym i ciekawa treść, po które powrócą stali czytelnicy Twojego projektu! To skupienie się na jakości sprawi, że Twój zasób będzie poszukiwany i popularny

Życzę powodzenia w biznesie internetowym

Robots.txt został stworzony, aby regulować zachowanie robotów wyszukiwania w witrynach, a mianowicie, gdzie mogą przejść i przeprowadzić wyszukiwanie, a gdzie nie. Jakieś 10 lat temu moc tego pliku była świetna, wszystkie wyszukiwarki działały zgodnie z jego zasadami, ale teraz jest to bardziej rekomendacja niż reguła.

Ale dopóki nie zostanie anulowane, webmasterzy powinni to zrobić i poprawnie skonfigurować w oparciu o strukturę i hierarchię witryn. Osobnym motywem jest WordPress, ponieważ CMS zawiera wiele elementów, których nie trzeba przeszukiwać i indeksować. Zastanówmy się, jak poprawnie skomponować robots.txt

Gdzie jest plik robots w WordPress

W każdym z zasobów plik robots.txt musi znajdować się w folderze głównym. W przypadku WordPress, gdzie znajduje się folder wp-admin i tym podobne.

Lokalizacja serwera

Jeśli nie został utworzony lub załadowany przez administratora strony, to domyślnie nie zostanie znaleziony na serwerze. Standardowa kompilacja WordPressa nie przewiduje takiego obiektu.

Jak stworzyć poprawny txt robota

Stworzenie poprawnego pliku robots txt nie jest trudne, trudniej jest napisać w nim poprawne dyrektywy. Najpierw utwórz dokument, otwórz notatnik i kliknij Zapisz jako.

Zapisz dokument

Zapisz dokument W następnym oknie ustaw nazwę robotów, zostaw rozszerzenie txt, kodowanie ANSI i kliknij Zapisz. Obiekt pojawi się w folderze, w którym dokonano zapisu. Chociaż dokument jest pusty i niczego nie zawiera, zastanówmy się, które dyrektywy może obsługiwać.

Jeśli chcesz, możesz natychmiast pobrać go na serwer w katalogu głównym za pośrednictwem.

Zapisywanie robota

Zapisywanie robota Konfigurowanie poleceń

Istnieją cztery główne polecenia:

- User-agent: pokazuje reguły dla różnych robotów wyszukiwania, dla wszystkich lub dla niektórych

- Disalow: odmawia dostępu

- Zezwól: zezwól na dostęp

- Mapa strony: adres do mapy XML

Przestarzałe i niepotrzebne konfiguracje:

- Host: wskazuje główne lustro, stało się to niepotrzebne, ponieważ samo wyszukiwanie określi poprawną opcję

- Crawl-delay: ogranicza czas spędzany przez robota na stronie, teraz serwery są wydajne i nie musisz się martwić o wydajność

- Clean-param: ogranicza pobieranie zduplikowanych treści, możesz je zarejestrować, ale nie będzie to miało sensu, wyszukiwarka zaindeksuje wszystko, co jest na stronie i pobierze maksymalne strony

Przykładowe instrukcje pracy dla WordPress

Faktem jest, że robot wyszukujący nie lubi zabraniać dyrektyw i nadal będzie wprowadzał w obieg to, czego potrzebuje. Zakaz indeksowania powinien dotyczyć obiektów, które nie powinny znajdować się w 100% w wyszukiwaniu oraz w bazach danych Yandex i Google. Umieść ten działający przykład kodu w robots txt.

User-agent: * Disallow: / wp- Disallow: / tag / Disallow: * / trackback Disallow: * / strona Disallow: / autor / * Disallow: /template.html Disallow: /readme.html Disallow: *? Replytocom Allow: * / uploads Zezwalaj: * .js Zezwalaj: * .css Zezwalaj: * .png Zezwalaj: * .gif Zezwalaj: * .jpg Mapa strony: https: // twoja domena / sitemap.xml

Zastanówmy się nad tekstem i zobaczmy, na co dokładnie pozwoliliśmy, a czego zabroniliśmy:

- User-agent, umieść znak *, informując tym samym, że wszystkie wyszukiwarki muszą przestrzegać zasad

- Blok z Disallow uniemożliwia indeksowanie wszystkich stron technicznych i duplikatów. zauważ, że zablokowałem foldery zaczynające się od wp-

- Blok Zezwalaj umożliwia skanowanie skryptów, obrazów i pliki css, jest to niezbędne do poprawnej prezentacji projektu w wyszukiwarce, w przeciwnym razie ochraniacz do butów otrzymasz bez rejestracji

- : pokazuje ścieżkę do mapy witryny XML, należy ją wykonać, a także zastąpić napis "twoja domena"

Resztę dyrektyw polecam nie dodawać, po zapisaniu i wprowadzeniu zmian wczytać standardowy plik robots txt do katalogu głównego WordPressa. Aby sprawdzić dostępność, otwórz następujący adres https: //twoja-domena/robots.txt, zamień domenę na własną, powinna wyglądać tak.

Adres w ciągu zapytania

Adres w ciągu zapytania Jak sprawdzić, czy plik robots.txt działa?

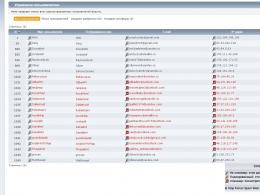

Standardowy sposób sprawdź za pośrednictwem serwisu webmasterów Yandex. Aby uzyskać lepszą analizę, musisz zarejestrować się i zainstalować usługę na stronie. Na górze widzimy załadowane roboty, klikamy check.

Sprawdzanie dokumentu w Yandex

Sprawdzanie dokumentu w Yandex Poniżej pojawi się blok z błędami, jeśli ich tam nie ma, to przejdź do następnego kroku, jeśli polecenie wyświetla się niepoprawnie, to poprawiamy i sprawdzamy ponownie.

Brak błędów w walidatorze

Brak błędów w walidatorze Sprawdźmy, czy Yandex poprawnie przetwarza polecenia, zejdź trochę niżej, wprowadź dwa zabronione i dozwolone adresy, nie zapomnij kliknąć sprawdź. Na obrazku widzimy, że instrukcja zadziałała, na czerwono zaznaczono, że wejście jest zabronione, a zielonym haczykiem, że indeksowanie rekordów jest dozwolone.

Sprawdzanie folderów i stron w Yandex

Sprawdzanie folderów i stron w Yandex Sprawdziliśmy, że wszystko działa, przejdźmy do kolejnej metody - ustawiania robotów za pomocą wtyczek. Jeśli proces nie jest jasny, obejrzyj nasz film.

Wtyczka wirtualnego generatora robots.txt

Jeśli nie chcesz zadzierać z Połączenie FTP wtedy na ratunek przychodzi jedna świetna wtyczka generatora WordPressa o nazwie Virtual Robots.txt. Instalujemy go standardowo z panelu administracyjnego WordPressa przeszukując lub pobierając archiwum, wygląda to tak.

Jak wygląda plik Virtual Robots.txt

Jak wygląda plik Virtual Robots.txt Ustawienia> Wirtualny Robots.txt, widzimy znajomą konfigurację, ale musimy ją zastąpić naszą z artykułu. Kopiuj i wklej, nie zapomnij zapisać.

Konfigurowanie Virtual Robots.txt

Konfigurowanie Virtual Robots.txt Roboty zostaną utworzone automatycznie i będą dostępne pod tym samym adresem. Jeśli chcesz sprawdzić, czy jest w plikach WordPress, nic nie zobaczymy, ponieważ dokument jest wirtualny i można go edytować tylko z wtyczki, ale Yandex i Google to zobaczą.

Dodaj z Yoast SEO

Słynna wtyczka Yoast SEO umożliwia dodawanie i zmianę pliku robots.txt z pulpitu WordPress. Ponadto utworzony plik pojawia się na serwerze (a nie wirtualnie) i znajduje się w katalogu głównym serwisu, czyli po usunięciu lub dezaktywacji robot pozostaje. Przejdź do Narzędzia> Edytor.

Edytor plików Yoast SEO

Edytor plików Yoast SEO Jeśli są roboty, to zostanie wyświetlone na stronie, jeśli nie ma przycisku „utwórz”, kliknij go.

Przycisk tworzenia robotów

Przycisk tworzenia robotów Pole tekstowe wyjdzie, wpisz istniejący tekst z konfiguracji uniwersalnej i zapisz. Możesz sprawdzić połączenie FTP, w którym pojawi się dokument.

Modyfikuj według modułu w SEO All in One

Stara wtyczka All in One SEO może zmienić robots txt, aby aktywować możliwość, przejdź do sekcji modułów i znajdź element o tej samej nazwie, kliknij Aktywuj.

Moduły w All In one Seo

Moduły w All In one Seo Pojawi się menu All in One SEO nowa sekcja, wejdź, widzimy funkcjonalność konstruktora.

Praca w module AIOS

Praca w module AIOS - Nazwisko agenta wpisujemy, w naszym przypadku * lub zostawiamy puste

- Zezwalaj lub odmawiaj indeksowania

- Katalog lub strona, do której nie musisz iść

- Wynik

Moduł nie jest wygodny, trudno na tej zasadzie stworzyć poprawny i poprawny robots.txt. Lepiej użyć innych narzędzi.

Prawidłowa konfiguracja wtyczki WooCommerce

Aby poprawnie skonfigurować wtyczkę sklepu internetowego WordPress WooCommerce, dodaj te wiersze do pozostałych:

Disallow: / koszyk / Disallow: / kasa / Disallow: / * dodaj do koszyka = *

Robimy to samo i przesyłamy go na serwer przez FTP lub wtyczkę.

Wynik

Podsumujmy, co należy zrobić, aby witryna WordPress zawierała odpowiedni plik dla wyszukiwarek:

- Utwórz plik ręcznie lub za pomocą wtyczki

- Zapisujemy w nim instrukcje z artykułu

- Przesyłanie na serwer

- Sprawdzanie w walidatorze Yandex

- Nie używaj generatorów robots txt w Internecie, ruszaj trochę rękoma

Ulepsz swoje blogi WordPress, promuj i odpowiednio skonfiguruj wszystkie parametry, a my Ci w tym pomożemy, sukces!

Od autora: jednym z plików używanych przez wyszukiwarki podczas indeksowania Twojej witryny jest plik robots.txt. Z nazwy pliku nietrudno zrozumieć, że jest on używany dla robotów. Rzeczywiście, ten plik pozwala powiedzieć robotowi wyszukiwania, co może być indeksowane w Twojej witrynie, a czego nie chcesz widzieć w indeks wyszukiwania... Przyjrzyjmy się więc, jak skonfigurować plik robots txt dla witryny WordPress.

W sieci jest wiele artykułów na ten temat. W prawie każdym z tych artykułów można znaleźć własną wersję pliku robots txt, którą można pobrać i wykorzystać z niewielką edycją lub bez niej w witrynie WordPress. Nie będę ponownie przepisywać jednej z tych opcji w tym artykule, ponieważ nie ma w tym żadnego szczególnego sensu - wszystkie te opcje można łatwo znaleźć w sieci. W tym artykule po prostu przeanalizujemy, jak stworzyć robots txt dla WordPressa i jakie powinny tam być minimalne zasady.

Zacznijmy od tego, gdzie powinien znajdować się plik robots.txt i co w nim pisać. Ten plik podobnie jak plik sitemap.xml musi znajdować się w katalogu głównym witryny, tj. powinien być dostępny pod adresem http://site/robots.txt

Spróbuj skontaktować się z tym adresem, zastępując słowo site adresem swojej witryny. Możesz zobaczyć coś takiego:

Chociaż możesz zobaczyć następujący obraz:

Można by powiedzieć, że to dziwna sytuacja. Rzeczywiście adres jest taki sam, ale w pierwszym przypadku akta są dostępne, w drugim nie. Jednocześnie, jeśli spojrzysz na katalog główny witryny, nie znajdziesz tam żadnego pliku robots.txt. Jak i gdzie znajduje się plik robots.txt w WordPressie?

Wszystko sprowadza się do łatwej konfiguracji — to konfiguracja CNC. Jeśli Twoja witryna ma włączoną obsługę CNC, zobaczysz dynamicznie generowany silnik robots.txt. V Inaczej zostanie zwrócony błąd 404.

Włącz system CNC w menu Ustawienia — Permalinki, zaznaczając ustawienie Nazwa rekordu. Zapiszmy zmiany - teraz plik robots.txt będzie generowany dynamicznie przez silnik.

Jak widać na pierwszym rysunku, plik ten używa pewnych dyrektyw, które ustalają pewne zasady, a mianowicie zezwalają lub zabraniają indeksowania czegoś pod danym adresem. Jak można się domyślić, dyrektywa Disallow wyłącza indeksowanie. W tym przypadku jest to cała zawartość folderu wp-admin. Cóż, dyrektywa Allow umożliwia indeksowanie. W moim przypadku dozwolone jest indeksowanie pliku admin-ajax.php z wyżej zabronionego folderu wp-admin.

Generalnie wyszukiwarki nie potrzebują tego pliku, oczywiście nie wyobrażam sobie nawet z jakich powodów WordPress napisał tę regułę. No tak, w zasadzie nie mam nic przeciwko

Przy okazji dodałem konkretnie frazę „w moim przypadku” powyżej, ponieważ w twoim przypadku zawartość robots.txt może już być inna. Na przykład może zostać zabroniony indeksowania wp-zawiera folder.

Oprócz dyrektyw Disallow i Allow w pliku robots.txt widzimy dyrektywę User-agent, dla której gwiazdka jest określona jako wartość. Gwiazdka oznacza, że następny zestaw reguł dotyczy wszystkich wyszukiwarek. Możesz także podać nazwy konkretnych wyszukiwarek zamiast gwiazdki. Plik robots.txt obsługuje również inne dyrektywy. Nie będę się nad nimi rozwodził, wszystkie z przykładami można obejrzeć w konsoli webmastera Google lub Yandex. Możesz również zapoznać się z informacjami na tej stronie.

Jak stworzyć robots txt dla WordPress

Mamy więc plik do wyszukiwania robotów, ale prawdopodobnie nie będzie Ci odpowiadał w obecnej formie. Jak skomponować swój plik. Jest tu kilka opcji. Zacznijmy od pierwszego - ręcznego tworzenia pliku. Utwórz zwykły Dokument tekstowy w notatniku i zapisz go jako roboty z rozszerzeniem txt. W tym pliku napisz wymagany zestaw reguły i po prostu zapisz go w katalogu głównym witryny WordPress, obok pliku konfiguracyjnego wp-config.php.

Na wszelki wypadek sprawdź, czy plik został pobrany i jest dostępny, otwierając go w przeglądarce. To był pierwszy sposób. Druga metoda to ta sama dynamiczna generacja plików, tylko teraz zrobi to wtyczka. Jeśli korzystasz z popularnej wtyczki All in One SEO, możesz skorzystać z jednego z jej modułów.

Ten artykuł jest przykładem optymalnego, moim zdaniem, kodu dla pliku robots.txt dla WordPressa, który możesz wykorzystać w swoich witrynach.

Najpierw pamiętajmy dlaczego plik robots.txt jest potrzebny- Plik robots.txt jest potrzebny wyłącznie robotom wyszukiwania, aby „powiedziały” im, które sekcje/strony witryny mają odwiedzić, a które nie muszą być odwiedzane. Strony zamknięte przed odwiedzeniem nie zostaną uwzględnione w indeksie wyszukiwarek (Yandex, Google itp.).

Opcja 1: optymalny kod robots.txt dla WordPress

User-agent: * Disallow: / cgi-bin # classic ... Disallow: /? # wszystkie parametry żądania w głównym Disallow: /wp- # wszystkie pliki WP: /wp-json/, /wp-includes, /wp-content/plugs Disallow: *?s = # Disallow search: * & s = # Disallow search: / search # search Disallow: / author / # archiwum autora Disallow: * / embed # wszystkie embeds Disallow: * / page / # wszystkie rodzaje paginacji Allow: * / uploads # open uploads Allow: /*/*.js # inside /wp - (/ * / - dla priorytetu) Allow: /*/*.css # inside /wp- (/* / - dla priorytetu) Allow: /wp-*.png # zdjęcia we wtyczkach, folderze pamięci podręcznej itp. . Zezwalaj: /wp-*.jpg # zdjęcia w wtyczkach, folderze pamięci podręcznej itp. Zezwól: /wp-*.jpeg # zdjęcia w wtyczkach, folderze pamięci podręcznej itp. Zezwalaj: /wp-*.gif # zdjęcia w wtyczkach, folderze pamięci podręcznej itp. Zezwól: /wp-*.svg # zdjęcia w wtyczkach, folderze pamięci podręcznej itp. Zezwalaj na: /wp-*.pdf # pliki w wtyczkach, folderze pamięci podręcznej itp. Zezwól: /wp-admin/admin-ajax.php #Disallow: /wp/# gdy WP jest zainstalowany w podkatalogu mapy witryny wp: http://example.com/sitemap.xml Mapa witryny: http://example.com/sitemap2 .xml # inny #Plik mapy witryny: http://example.com/sitemap.xml.gz # wersja skompresowana (.gz) # Wersja kodu: 1.1 # Nie zapomnij zmienić `site.ru` na swoją stronę.Analiza kodu:

- Disallow: / cgi-bin - zamyka katalog skryptów na serwerze

- Disallow: / feed - zamyka kanał RSS bloga

- Disallow: / trackback - zamyka powiadomienia

- Disallow:? S = lub Disallow: *? S = - zamyka strony wyszukiwania

- Disallow: * / page / - zamyka wszystkie rodzaje paginacji

Reguła mapy witryny: http://example.com/sitemap.xml kieruje robota do pliku XML mapy witryny. Jeśli masz taki plik na swojej stronie, zapisz do niego pełną ścieżkę. Takich plików może być kilka, wtedy podajemy ścieżkę do każdego z osobna.

W wierszu Host: site.ru wskazujemy główne lustro witryny. Jeśli witryna ma lustra (kopie witryny w innych domenach), to aby Yandex indeksował je wszystkie w ten sam sposób, musisz określić główne lustro. Dyrektywa gospodarza: tylko Yandex rozumie, Google nie rozumie! Jeśli witryna działa w ramach protokołu https, należy ją określić w Host: Host: http://example.com

Z dokumentacji Yandex: „Host jest niezależną dyrektywą i działa w dowolnym miejscu pliku (przecinający się).” Dlatego umieszczamy go na górze lub na samym końcu pliku, w pustym wierszu.

W wierszu User-agent: * wskazujemy, że wszystkie poniższe reguły będą działać dla wszystkich robotów wyszukiwania *. Jeśli chcesz, aby te reguły działały tylko dla jednego konkretnego robota, zamiast * podajemy nazwę robota (User-agent: Yandex, User-agent: Googlebot).

W linii Allow: * / uploads celowo dopuszczamy indeksowanie stron, które zawierają / uploads. Ta zasada jest obowiązkowa, ponieważ powyżej zabraniamy indeksowania stron zaczynających się od /wp- i / wp- jest zawarty w / wp-content / przesyłane... Dlatego, aby złamać regułę Disallow:/wp-, potrzebna jest linia Allow:*/uploads, ponieważ linki takie jak / wp-content / przesłane / ... możemy mieć zdjęcia, które powinny być zindeksowane, a także niektóre pobrane pliki, których nie trzeba ukrywać. Zezwól: może być „przed” lub „po” Disallow:.

Pozostałe wiersze zabraniają robotom „chodzenia” po łączach zaczynających się od:

Ponieważ obecność otwartych kanałów jest wymagana, na przykład w przypadku Yandex Zen, gdy trzeba podłączyć witrynę do kanału (dzięki komentatorowi „Digital”). Może otwarte kanały są potrzebne gdzie indziej.

Jednocześnie kanały mają swój własny format w nagłówkach odpowiedzi, dzięki czemu wyszukiwarki rozumieją, że tak nie jest strona HTML, paszę i oczywiście zajmij się nią w inny sposób.

Dyrektywa Host dla Yandex nie jest już potrzebna

Yandex całkowicie rezygnuje z dyrektywy Host, zastąpiono ją przekierowaniami 301. Hosta można bezpiecznie usunąć z pliku robots.txt. Jednak ważne jest, aby wszystkie serwery lustrzane miały przekierowanie 301 do witryny głównej (dublowania głównego).

To ważne: sortowanie reguł przed przetwarzaniem

Yandex i Google przetwarzają dyrektywy Allow i Disallow w kolejności, w jakiej zostały określone, ale najpierw sortują je od krótkiej do długiej, a następnie przetwarzają ostatnią pasującą regułę:

User-agent: * Allow: * / uploads Disallow: / wp-

będzie odczytywany jako:

User-agent: * Disallow: / wp- Allow: * / uploads

Aby szybko zrozumieć i zastosować funkcję sortowania, pamiętaj o tej zasadzie: „im dłuższa reguła w pliku robots.txt, tym wyższy ma priorytet. Jeśli długość reguł jest taka sama, priorytet ma dyrektywa Zezwól”.

Opcja 2: standardowy plik robots.txt WordPress

Nie wiem jak ktokolwiek, ale jestem za pierwszą opcją! Ponieważ jest to bardziej logiczne - nie trzeba całkowicie powielać sekcji, aby określić dyrektywę Host dla Yandex, która jest intersekcyjna (rozumiana przez robota w dowolnym miejscu szablonu, bez określania, do którego robota należy). Jeśli chodzi o niestandardową dyrektywę Allow, to działa ona dla Yandex i Google, a jeśli nie otworzy folderu uploads dla innych robotów, które jej nie rozumieją, to 99% nie pociągnie za sobą niczego niebezpiecznego. Nie zauważyłem jeszcze, że pierwsze roboty nie działają tak, jak powinny.

Powyższy kod jest nieco niepoprawny. Dziękuję komentatorowi „” za wskazanie niepoprawności, chociaż sam musiałem to rozgryźć. A oto co wymyśliłem (mogę się mylić):

- Host dyrektywy Yandex: należy użyć po Disallow:, ponieważ niektóre roboty (nie Yandex i Google) mogą go nie rozumieć i generalnie odrzucają plik robots.txt. Sam Yandex, sądząc po dokumentacji, absolutnie nie dba o to, gdzie i jak używać Host:, chociaż generalnie tworzy robots.txt z tylko jedną linią Host: www.site.ru, aby skleić wszystkie lustra witryny.

Niektóre roboty (nie Yandex i Google) nie rozumieją więcej niż 2 dyrektyw: User-agent: i Disallow:

3. Mapa strony: przekrojowa dyrektywa dla Yandex i Google, a także dla wielu innych robotów, więc piszemy ją na końcu w pustej linii i będzie działać dla wszystkich robotów jednocześnie.

Na podstawie tych poprawek poprawny kod powinien wyglądać tak:

Agent użytkownika: Yandex Disallow: / wp-admin Disallow: / wp-includes Disallow: / wp-content / plugins Disallow: / wp-json / Disallow: /wp-login.php Disallow: /wp-register.php Disallow: * / embed Disallow: * / page / Disallow: / cgi-bin Disallow: *?s = Allow: /wp-admin/admin-ajax.php Host: site.ru User-agent: * Disallow: / wp-admin Disallow : / wp-includes Disallow: / wp-content / plugins Disallow: / wp-json / Disallow: /wp-login.php Disallow: /wp-register.php Disallow: * / embed Disallow: * / strona / Disallow: / cgi-bin Disallow: *?s = Allow: /wp-admin/admin-ajax.php Mapa witryny: http://example.com/sitemap.xmlDodajemy dla siebie

Jeśli chcesz zabronić dalszych stron lub grup stron, możesz dodać regułę (dyrektywę) poniżej Uniemożliwić:... Na przykład musimy zamknąć wszystkie wpisy w kategorii z indeksowania. Aktualności wtedy wcześniej Mapa strony: dodaj regułę:

Nie zezwalaj: / aktualności

Zabrania robotom korzystania z takich linków:

- http://example.com/wiadomości

- http://example.com/aktualnosci/drugoe-nazvanie/

Jeśli chcesz zamknąć jakiekolwiek wystąpienia / news, napisz:

Nie zezwalaj: * / aktualności

- http://example.com/wiadomości

- http://example.com/moje/aktualnosci/drugoe-nazvanie/

- http://example.com/category/newsletter-nazvanie.html

Możesz dowiedzieć się więcej o dyrektywach robots.txt na stronie pomocy Yandex (ale pamiętaj, że nie wszystkie opisane tam reguły działają w Google).

Sprawdzanie i dokumentacja robots.txt

Możesz sprawdzić, czy zalecane reguły działają poprawnie, korzystając z linków:

- Yandex: http://webmaster.yandex.ru/robots.xml.

- Google robi to w Konsola wyszukiwania... Potrzebujesz autoryzacji i dostępności strony w panelu webmastera...

- Usługa tworzenia pliku robots.txt: http://pr-cy.ru/robots/

- Usługa tworzenia i sprawdzania robots.txt: https://seolib.ru/tools/generate/robots/

Zapytałem Yandex ...

Zadałem w nich pytanie. Wsparcie Yandex w zakresie intersekcyjnego użycia dyrektyw Host i Sitemap:

Pytanie:

Witam!

Piszę artykuł o pliku robots.txt na moim blogu. Chciałbym uzyskać odpowiedź na to pytanie (w dokumentacji nie znalazłem jednoznacznego „tak”):Jeśli muszę skleić wszystkie lustra i do tego używam dyrektywy Host na samym początku pliku robots.txt:

Host: site.ru Klient użytkownika: * Disallow: / asd

Czy będzie? ten przykład działać poprawnie Host: site.ru? Czy wskaże robotom, że site.ru jest głównym lustrem? Tych. Używam tej dyrektywy nie w sekcji, ale osobno (na początku pliku) bez określania, do którego agenta użytkownika się odnosi.

Chciałem również wiedzieć, czy dyrektywa Sitemap musi być używana wewnątrz sekcji, czy może być używana na zewnątrz: na przykład w pustym wierszu po sekcji?

User-agent: Yandex Disallow: / asd User-agent: * Disallow: / asd Mapa witryny: http://example.com/sitemap.xml

Czy robot w tym przykładzie zrozumie dyrektywę Sitemap?

Mam nadzieję, że otrzymam od Was odpowiedź, która rozwieje moje wątpliwości.

Odpowiedź:

Witam!

Dyrektywy hosta i mapy witryny są przekrojowe, więc będą używane przez robota niezależnie od tego, gdzie są określone w pliku robots.txt.

--

Z pozdrowieniami, Platon Szczukin

Wsparcie Yandex

Wniosek

Należy pamiętać, że zmiany w robots.txt na już działającej witrynie będą widoczne dopiero po kilku miesiącach (2-3 miesiące).

Plotka głosi, że Google może czasami zignorować reguły w pliku robots.txt i umieścić stronę w indeksie, jeśli uważa, że strona jest bardzo unikalna i użyteczna i musi znajdować się w indeksie. Jednak inne plotki obalają tę hipotezę, ponieważ niedoświadczeni optymalizatorzy mogą błędnie określić reguły w pliku robots.txt i tak blisko wymagane strony z indeksowania i zostaw niepotrzebne. Bardziej skłaniam się ku drugiemu założeniu...

Dynamiczny plik robots.txt

W WordPressie żądanie pliku robots.txt jest przetwarzane osobno i wcale nie jest konieczne fizyczne tworzenie pliku robots.txt w katalogu głównym witryny, co więcej nie jest to zalecane, ponieważ przy takim podejściu będzie to bardzo trudno wtyczkom zmienić ten plik, a czasami jest to konieczne.

Przeczytaj o tym, jak działa dynamiczne tworzenie pliku robots.txt w opisie funkcji, a poniżej podam przykład, jak możesz zmienić zawartość tego pliku w locie, za pomocą hooka.

Aby to zrobić, dodaj następujący kod do pliku functions.php:

Add_action („do_robotstxt”, „my_robotstxt”); function my_robotstxt () ($ linie = ["User-agent: *", "Disallow: / wp-admin /", "Disallow: / wp-includes /", "",]; echo implode ("\ r \ n ", $ linie); kostka; // zakończ PHP)

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes /

Crawl-delay - limit czasu dla szalonych robotów (nie brany pod uwagę od 2018 r.)

Yandex.

Po przeanalizowaniu listów przesłanych do naszego wsparcia w sprawie problemów z indeksowaniem w ciągu ostatnich dwóch lat, stwierdziliśmy, że jedną z głównych przyczyn powolnego pobierania dokumentów jest niepoprawnie skonfigurowana dyrektywa Crawl-delay w pliku robots.txt [...] Tak więc że właściciele witryn nie muszą się już tym martwić i aby wszystkie naprawdę potrzebne strony witryn pojawiały się i szybko aktualizowały w wyszukiwaniu, postanowiliśmy zrezygnować z dyrektywy Crawl-delay.

Kiedy robot Yandex indeksuje witrynę jak szalony, powoduje to niepotrzebne obciążenie serwera. Robota można poprosić o „zwolnienie”.

Aby to zrobić, musisz użyć dyrektywy Crawl-delay. Wskazuje czas w sekundach, przez który robot musi stać bezczynnie (czekać), aby zaindeksować każdą następną stronę witryny.

W celu zapewnienia zgodności z robotami, które słabo przestrzegają standardu robots.txt, opóźnienie indeksowania należy określić w grupie (w sekcji User-Agent) bezpośrednio po opcji Zabroń i Zezwól

Robot Yandex rozumie wartości ułamkowe, na przykład 0,5 (pół sekundy). Nie gwarantuje to, że robot wyszukiwania będzie odwiedzał Twoją witrynę co pół sekundy, ale przyspieszy indeksowanie witryny.

User-agent: Yandex Disallow: / wp-admin Disallow: / wp-includes Crawl-delay: 1,5 # limit czasu za 1,5 sekundy User-agent: * Disallow: / wp-admin Disallow: / wp-includes Allow: / wp- * .gif Crawl-delay: 2 # limit czasu w 2 sekundy

Googlebot nie rozumie dyrektywy o opóźnieniu indeksowania. Limit czasu dla jego robotów można określić w panelu webmastera.

W serwisie avi1.ru możesz kupić teraz Promocja SMM w ponad 7 najpopularniejszych w sieciach społecznościowych... Czyniąc to, zwracaj uwagę na wystarczającą ilość niska cena wszystkie usługi witryny.