Wordpress txt роботтарын жасаңыз. WooCommerce плагинін дұрыс орнату

Бәріңе сәлем! Бүгінгі мақала не болуы керек туралы дұрыс файл WordPress үшін robots.txt. Біз бірнеше күн бұрын функциялар мен мақсатты қарастырдық, енді WordPress үшін нақты мысалды талдаймыз.

Бұл файлдың көмегімен бізде әртүрлі іздеу жүйелері үшін негізгі индекстеу ережелерін орнату, сондай-ақ жеке іздеу боттарына кіру құқықтарын тағайындау мүмкіндігі бар. Мысалмен мен сізге қалай жазу керектігін көрсетемін дұрыс robots.txt wordpress үшін. Екі негізгіге негізделген іздеу жүйелері— Yandex және Google.

Веб-шеберлердің тар шеңберлерінде сіз Яндекс үшін пайдаланушы-агентке сілтеме жасай отырып, бөлек бөлім жасау керек деген пікірге тап болуыңыз мүмкін: Яндекс. Бұл нанымдар неге негізделгенін бірге анықтайық.

Яндекс директиваларды қолдайды Таза парамжәне Хост, бұл туралы Google білмейді және сканерлеу кезінде пайдаланбайды.

Оларды тек Яндекс үшін пайдалану орынды, бірақ бір нюанс бар - бұл файлдың кез келген жерінде орналастыруға болатын қиылысу директивалары және Google оларды жай ғана ескермейді. Бұл жағдайда, егер индекстеу ережелері екі іздеу жүйесі үшін де бірдей болса, онда барлық іздеу роботтары үшін User-агент: * пайдалану жеткілікті.

Пайдаланушы-агент арқылы роботтарға қол жеткізген кезде, файл жоғарыдан төмен қарай оқылатынын және өңделетінін есте ұстаған жөн, сондықтан User-агент: Яндекс немесе Пайдаланушы-агент: Googlebot көмегімен бұл бөлімдер бастапқыда орналастырылуы керек. файл.

WordPress үшін Robots.txt мысалы

Мен сізге бірден ескерткім келеді: WordPress-те жұмыс істейтін барлық сайттарға сәйкес келетін тамаша файл жоқ! Файлдың мазмұнын өзіңіздің нақты жағдайыңыз үшін талдамай, соқыр көшіру арқылы алданып қалмаңыз! Көп нәрсе таңдалған тұрақты сілтеме параметрлеріне, сайттың құрылымына және тіпті байланысты орнатылған плагиндер. Мен CNC қолданылатын мысалды және /%postname%/ сияқты тұрақты сілтемелерді қарап жатырмын.

Кез келген мазмұнды басқару жүйесі сияқты оның өзінің әкімшілік ресурстары, басқару каталогтары және іздеу жүйесінің индексіне қосылмауы керек басқа да нәрселер бар. Мұндай беттерді кіруден қорғау үшін оларды осы файлда келесі жолдармен индекстеуге тыйым салу қажет:

Рұқсат етпеу: /cgi-bin Рұқсат етпеу: /wp-

Екінші жолдағы директива /wp- арқылы басталатын барлық каталогтарға кіруді блоктайды, соның ішінде:

- wp-admin

- wp-мазмұн

- wp қамтиды

Бірақ біз суреттер әдепкі бойынша қалтаға жүктелетінін білеміз жүктеп салулар, ол каталогтың ішінде wp-мазмұн. Оларды жол арқылы индекстеуге рұқсат етейік:

рұқсат ету: */жүктеп салуларБіз қызмет файлдарын жаптық, біз бір домен ішінде азайып, сайтты сүзу ықтималдығын арттыратын негізгі мазмұны бар көшірмелерді жоюға көшеміз. Көшірмелерге санат беттері, авторлар, тегтер, RSS арналары, сонымен қатар беттеу, трекбэктер және жеке пікірлер беттері кіреді. Олардың индекстеуін өшіруді ұмытпаңыз:

Рұқсат етпеу: /санат/ Рұқсат ету: /автор/ Рұқсат ету: /бет/ Рұқсат ету: /тег/ Рұқсат ету: */арна/ Рұқсат ету: */бақылау.

Әрі қарай, мен сияқты аспектіге ерекше назар аударғым келеді. Егер сіз CNC пайдалансаңыз, URL мекенжайында сұрақ белгілері бар беттер жиі «артық» болады және негізгі мазмұнды қайталайды. Мұндай параметр беттерін бірдей өшіру керек:

Рұқсат етпеу: */?

Бұл ереже қарапайым тұрақты сілтемелерге?p=1 , іздеу сұраулары?s= бар беттерге және басқа параметрлерге қолданылады. Тағы бір мәселе URL мекенжайындағы жыл, айды қамтитын мұрағат беттері болуы мүмкін. Шындығында, 20* маскасы арқылы оларды жабу өте оңай, осылайша мұрағаттарды жылдар бойынша индекстеуге тыйым салынады:

Рұқсат етпеу: /20*

Индекстеуді жылдамдату және аяқтау үшін орынға жолды қосыңыз. Робот файлды өңдейді және сайтқа келесі жолы кіргенде, ол оны бірінші кезектегі беттерді тексеру үшін пайдаланады.

Сайт картасы: https://site/sitemap.xml

robots.txt файлында индекстеу сапасын жақсартатын роботтар үшін қосымша ақпаратты орналастыруға болады. Олардың ішінде Host директивасы Яндекс үшін мынаны көрсетеді:

Хост: webliberty.ruСайт HTTPS арқылы жұмыс істегенде, сіз протоколды көрсетуіңіз керек:

Хост: https://web

2018 жылдың 20 наурызынан бастап Яндекс ресми түрде Host директивасын қолдауды тоқтатты. Оны robots.txt файлынан алып тастауға болады, егер қалдырылған болса, робот оны елемейді.

Қорытындылай келе, мен жоғарыда айтылғандардың барлығын біріктіріп, WordPress-ке арналған robots.txt файлының мазмұнын алдым, мен оны бірнеше жыл бойы пайдаланып келемін және сонымен бірге индексте қайталанатындар жоқ:

Пайдаланушы-агент: * Рұқсат ету: /cgi-bin Рұқсат ету: /wp- Рұқсат ету: /санат/ Рұқсат ету: /автор/ Рұқсат ету: /бет/ Рұқсат ету: /тег/ Рұқсат ету: */feed/ Рұқсат ету: /20 * Рұқсат етпеу: * /treckback Рұқсат етпеу: */пікірлер Рұқсат етпеу: */? Рұқсат ету: */uploads Сайт картасы: https://site/sitemap.xml

Индекстеу барысын үнемі қадағалап отырыңыз және көшірмелер болған жағдайда файлды уақытында түзетіңіз.

Көп нәрсе файлдың дұрыс құрастырылғанына немесе құрастырылмағанына байланысты, сондықтан іздеу жүйелері сайтты жылдам және тиімді индекстеу үшін оның құрастырылуына ерекше назар аударыңыз. Егер сізде сұрақтар болса - сұраңыз, мен жауап беруге қуаныштымын!

Сәлем құрметті оқырмандар! «Бизнес анатомиясы» жобасы және веб-шебер Александр сіздермен бірге. Біз «WordPress сайтында қалай сайт құру және одан ақша табу» нұсқаулығындағы мақалалар сериясын жалғастырамыз және бүгін WordPress үшін robots.txt файлын қалай жасау керек және бұл файл не үшін қажет екендігі туралы сөйлесеміз.

Өткен 16 сабақта біз көп материалды оқыдық. Біздің сайт оны қызықты мазмұнмен және SEO оңтайландыруымен толтыруға дайын.

Сонымен, іске кірісейік!

Сайтқа robots.txt файлы не үшін қажет?

Біздің сайттағы басты құндылық мазмұн болады, бірақ оған қосымша сайтта іздеу роботы үшін құнды емес көптеген техникалық бөлімдер немесе беттер бар.

Бұл бөлімдерге мыналар кіреді:

- админ. панель

- Іздеу

- индекстеуден түсініктемелерді жабғыңыз келуі мүмкін

- немесе URL мекенжайларында бірдей таңбалары бар кейбір қайталанатын беттер

Жалпы, robots.txt іздеу роботының белгілі бір беттерді индекстеуіне жол бермеу үшін жасалған.

Бір кездері роботтардың txt қалай жұмыс істейтінін түсінуге бұл сурет маған көп көмектесті:

Көріп отырғанымыздай, сайтқа келгенде тексеріп шығушы жасайтын бірінші нәрсе - осы нақты Файлды іздеу! Оны талдағаннан кейін ол қандай анықтамалықтарды енгізу керектігін және қайсысын енгізу керектігін түсінеді.

Көптеген жаңа бастаған веб-шеберлер бұл файлды елемейді, бірақ бекер! Өйткені сіздің сайтыңызды индекстеу қаншалықты «таза» болатыны оның іздеу жүйесіндегі орнына байланысты.

WordPress үшін robots.txt файлын жазу мысалы

Енді осы файлды қалай жазу керектігін анықтайық. Мұнда күрделі ештеңе жоқ, оны жазу үшін бізге әдеттегіні ашу керек мәтіндік редакторБлокнот немесе сіз notepad+ сияқты кәсіби редакторды пайдалана аласыз.

Редакторға келесі деректерді енгізіңіз:

Пайдаланушы агенті: Yandex

Рұқсат етпеу: /wp-admin

Рұқсат етпеу: /wp-includes

Рұқсат етпеу: /wp-comments

Рұқсат етпеу: /wp-content/themes

Рұқсат етпеу: /wp-login.php

Рұқсат етпеу: /wp-register.php

Рұқсат етпеу: */backback

Рұқсат етпеу: */фид

Рұқсат етпеу: /cgi-bin

Рұқсат етпеу: *?s=

Хост: site.ruПайдаланушы-агент: *

Рұқсат етпеу: /wp-admin

Рұқсат етпеу: /wp-includes

Рұқсат етпеу: /wp-comments

Рұқсат етпеу: /wp-content/plugins

Рұқсат етпеу: /wp-content/themes

Рұқсат етпеу: /wp-login.php

Рұқсат етпеу: /wp-register.php

Рұқсат етпеу: */backback

Рұқсат етпеу: */фид

Рұқсат етпеу: /cgi-bin

Рұқсат етпеу: *?s=Сайт картасы: http://site.ru/sitemap.xml

Енді осының бәрімен айналысайық.

Бірінші назар аударатын нәрсе - файл екі үлкен блокқа бөлінген.

Ал әрбір блоктың басында бұл блок қай робот үшін жасалғанын көрсететін «Пайдаланушы-агент» каталогы орналасқан.

Біздің бірінші блок Яндекс роботтары үшін жасалды, бұған дәлел берілген жол: "Пайдаланушы-агент: Яндекс"

Екінші блок бұл барлық басқа роботтар үшін екенін айтады. Бұл «Пайдаланушы-агент: *» жұлдызшасымен көрсетілген.

«Рұқсат етпеу» каталогы қай бөлімдерді индекстеуге тыйым салынғанын белгілейді.

Енді оны бөлімдерге бөлейік:

/wp-admin- администраторды индекстеуге тыйым салу. панельдер

/wp- қамтиды- индекстеуге тыйым салу жүйелік қалталар WordPress қозғалтқышы

/wp-түсініктемелер- пікірлерді индекстеуге тыйым салу

/wp-content/plugins- WordPress плагиндері бар қалтаны индекстеуге тыйым салу

/wp-content/themes- WordPress үшін тақырыптары бар қалтаны индекстеуге тыйым салу

/wp-login.php- сайтқа кіру формасының индексіне тыйым салу

/wp-register.php- роботтан тіркеу формасын жабыңыз

*/арна- блогтың RSS арнасының индексіне тыйым салу

/cgi-bin- сервердегі сценарий каталогының индексіне тыйым салу

*?s=— құрамында?s= бар барлық URL мекенжайларын индекстеуге тыйым салу

Ал robots.txt ең соңында роботқа sitemap.xml файлы орналасқан жерді көрсетеміз

Сайт картасы: http://site.ru/sitemap.xml

Файл дайын болғаннан кейін оны сайттың түбірлік каталогында сақтаңыз.

Кейбір санаттарды индекстеуден қалай жабуға болады?

Мысалы, сайтыңызда іздеу роботтарына арналған бөлімді көрсеткіңіз келмейді. Мұның себептері мүлдем басқаша болуы мүмкін. Мысалы, сіз өзіңізді қалайсыз ба Күнделіксайтқа тұрақты келушілер ғана оқиды.

Бізге бірінші кезекте осы санаттың URL мекенжайын білу керек. Сірә, бұл /my-dnevnik болады.

Бұл бөлімді жабу үшін оған келесі жолды қосу жеткілікті: Рұқсат етпеу: /my-dnevnik

Robots.txt - әсерді қашан күтуге болады?

Жеке тәжірибемнен айта аламын, келесі жаңартуда сіз жапқан барлық айдарлар индекстен шығады деп күтпеуіңіз керек. Кейде бұл процесс екі айға дейін созылуы мүмкін. Тек сабырлы бол.

Сондай-ақ, Googlebots парақ қазірдің өзінде өте ерекше және қызықты деп есептесе, бұл файлды елемейтінін ескеру қажет.

ӘРҚАШАН есте қалатын нәрсе!

Әрине, техникалық компонент маңызды емес, бірақ ең алдымен пайдалы және назар аудару керек қызықты мазмұн, ол үшін жобаңыздың тұрақты оқырмандары оралады! Бұл сіздің ресурсыңызды сұранысқа ие және танымал ететін сапаға баса назар аудару.

Интернет бизнесіңізге сәттілік

Robots.txt сайттардағы іздеу роботтарының әрекетін реттеу үшін жасалған, атап айтқанда, олар қайда барып, оларды іздеуге қабылдай алады және қайда алмайды. Шамамен 10 жыл бұрын бұл файлдың күші керемет болды, барлық іздеу жүйелері оның ережелері бойынша жұмыс істеді, бірақ қазір ол ережеден гөрі ұсыныс сияқты.

Бірақ ол жойылмайынша, веб-шеберлер сайттардың құрылымы мен иерархиясының негізінде оны жасап, дұрыс орнатуы керек. Бөлек тақырып WordPress болып табылады, себебі CMS құрамында сканерлеуді және индекске беруді қажет етпейтін көптеген элементтер бар. Robots.txt файлын қалай дұрыс құрастыру керектігін анықтайық

Wordpress-те роботтар файлы қайда

Ресурстардың кез келгенінде robots.txt түбірлік қалтада болуы керек. WordPress жағдайында wp-admin қалтасы қайда және т.б.

Сервер орны

Егер ол сайт әкімшісімен жасалмаса және жүктелмесе, әдепкі бойынша оны серверде табу мүмкін емес. WordPress әдепкі құрылымы мұндай нысанды қамтамасыз етпейді.

Дұрыс роботтарды txt қалай жасауға болады

Дұрыс robots txt жасау қиын тапсырма емес, оған дұрыс директиваларды жазу қиынырақ. Алдымен құжат жасаңыз, блокнотты ашыңыз және басқаша сақтау түймесін басыңыз.

Құжатты сақтау

Құжатты сақтау Келесі терезеде роботтар атауын орнатыңыз, txt кеңейтімін, ANSI кодтауын қалдырыңыз және сақтау түймесін басыңыз. Нысан ол сақталған қалтада пайда болады. Құжат бос және ештеңені қамтымағанымен, оның қандай директиваларды қолдайтынын көрейік.

Қаласаңыз, оны серверге түбірге арқылы дереу жүктей аласыз.

Роботты сақтау

Роботты сақтау Пәрмен параметрлері

Мен төрт негізгі команданы бөлектеймін:

- Пайдаланушы-агент: барлығына немесе арнайы тексеріп шығуға арналған ережелерді көрсетеді

- Тыйым салу: кіруге тыйым салады

- Рұқсат ету: рұқсат беру

- Сайт картасы: XML картасының мекенжайы

Ескірген және қажетсіз конфигурациялар:

- Хост: негізгі айнаны көрсетеді, қажетсіз болды, өйткені іздеудің өзі дұрыс опцияны анықтайды

- Тексеру кешігуі: роботтың бетте қалу уақытын шектейді, енді серверлер қуатты және өнімділік туралы алаңдамаудың қажеті жоқ.

- Clean-param: қайталанатын мазмұнды жүктеуді шектейді, оны тіркеуге болады, бірақ мағынасы жоқ, іздеу жүйесі сайттағы барлық нәрсені индекстейді және беттердің максималды санын алады.

WordPress үшін жұмыс нұсқаулығы

Шындығында, іздеу роботы тыйым салатын нұсқауларды ұнатпайды және бәрібір айналымға қажет нәрсені қабылдайды. Индекстеуге тыйым салу 100% іздеуде және Яндекс пен Google дерекқорында болмауы керек объектілер болуы керек. Біз бұл жұмыс кодының мысалын robots txt файлында орналастырамыз.

Пайдаланушы-агент: * Рұқсат етпеу: /wp- Тыйым салу: /тег/ Рұқсат ету: */trackback Рұқсат ету: */бет Рұқсат ету: /автор/* Рұқсат ету: /template.html Тыйым салу: /readme.html Рұқсат ету: *?replytocom Рұқсат ету: */uploads Рұқсат ету: *.js Рұқсат ету: *.css Рұқсат ету: *.png Рұқсат ету: *.gif Рұқсат ету: *.jpg Сайт картасы: https://yourdomain/sitemap.xml

Мәтінмен айналысып, біз нені рұқсат еткенімізді және нені тыйым салғанымызды көрейік:

- Пайдаланушы-агент, * белгісін қойыңыз, осылайша барлық іздеу жүйелері ережелерге бағыну керек екенін көрсетеді

- Рұқсат етпеу мүмкіндігі бар блок барлық техникалық беттер мен көшірмелердің индекстелуіне тыйым салады. Мен wp- деп басталатын қалталарды бұғаттағанымды ескеріңіз

- Рұқсат ету блогы сценарийлерді, суреттерді және сканерлеуге мүмкіндік береді css файлдары, бұл іздеуде жобаны дұрыс көрсету үшін қажет, әйтпесе тіркелусіз аяқ киім аласыз

- : XML сайт картасына жолды көрсетеді, сіз оны міндетті түрде жасауыңыз керек, сонымен қатар «сіздің доменіңіз» деген жазуды ауыстыруыңыз керек.

Қалған директиваларды жасамауды ұсынамын, сақтау және өзгертулер енгізгеннен кейін біз стандартты роботтардың txt файлын WordPress түбіріне жүктейміз. Қолжетімділігін тексеру үшін мына мекенжайды ашыңыз https://your-domain/robots.txt, доменді өзіңіздікімен ауыстырыңыз, ол осылай көрсетілуі керек.

Сұрау жолындағы мекенжай

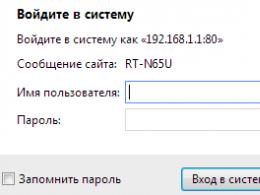

Сұрау жолындағы мекенжай robots.txt жұмыс істейтінін қалай тексеруге болады

Стандартты жол yandex веб-мастер қызметі арқылы тексеріңіз. Жақсырақ талдау үшін сайтта қызметті тіркеу және орнату қажет. Жоғарғы жағында біз жүктелген роботтарды көреміз, тексеру түймесін басыңыз.

Яндексте құжатты тексеру

Яндексте құжатты тексеру Төменде қателері бар блок пайда болады, егер жоқ болса, келесі қадамға өтіңіз, егер пәрмен дұрыс көрсетілмесе, түзетіп, қайтадан тексеріңіз.

Валидаторда қателер жоқ

Валидаторда қателер жоқ Яндекс пәрмендерді дұрыс өңдейтінін тексерейік, сәл төмен түсіп, екі тыйым салынған және рұқсат етілген мекенжайларды енгізіңіз, тексеруді басуды ұмытпаңыз. Суретте біз нұсқаудың жұмыс істегенін көреміз, қызыл белгі енгізуге тыйым салынғанын, ал жасыл құсбелгі жазбаларды индекстеуге рұқсат етілгенін көрсетеді.

Яндекстегі қалталар мен беттерді тексеру

Яндекстегі қалталар мен беттерді тексеру Біз тексердік, бәрі жұмыс істейді, келесі әдіске көшейік - плагиндерді пайдаланып роботтарды орнату. Процесс анық болмаса, біздің бейнені қараңыз.

Генератор плагині Virtual Robots.txt

Хабарласқыңыз келмесе FTP қосылымы, содан кейін Virtual Robots.txt деп аталатын бір керемет WordPress генератор плагині көмекке келеді. Біз оны мұрағатты іздеу немесе жүктеп алу арқылы WordPress басқару тақтасынан стандартты түрде орнатамыз, ол келесідей көрінеді.

Virtual Robots.txt файлы неге ұқсайды?

Virtual Robots.txt файлы неге ұқсайды? Параметрлер > Виртуалды роботтар.txt, біз таныс конфигурацияны көреміз, бірақ оны мақаладағы өзімізбен ауыстыруымыз керек. Көшіру және қою, сақтауды ұмытпаңыз.

Virtual Robots.txt файлын конфигурациялау

Virtual Robots.txt файлын конфигурациялау Роботтар автоматты түрде жасалады және сол мекенжайда қолжетімді болады. Егер сіз оның WordPress файлдарында бар-жоғын тексергіңіз келсе, біз ештеңе көрмейміз, себебі құжат виртуалды және оны тек плагиннен өңдеуге болады, бірақ ол Яндекс пен Google-ге көрінетін болады.

Yoast SEO көмегімен қосыңыз

Әйгілі Yoast SEO плагині WordPress бақылау тақтасынан robots.txt файлын қосу және өзгерту мүмкіндігін береді. Сонымен қатар, жасалған файл серверде пайда болады (және виртуалды емес) және сайттың түбірінде орналасқан, яғни жойылғаннан немесе өшірілгеннен кейін роботтар қалады. Құралдар > Өңдеу тармағына өтіңіз.

Yoast SEO файл редакторы

Yoast SEO файл редакторы Егер роботтар болса, ол бетте көрсетіледі, егер жоқ болса, «жасау» түймесі бар, оны басыңыз.

Роботтарды жасау түймесі

Роботтарды жасау түймесі Мәтіндік аймақ шығады, біз әмбебап конфигурациядан бар мәтінді жазып аламыз және оны сақтаймыз. Құжатты FTP қосылымы арқылы тексеруге болады.

Барлығы бір SEO модуліндегі модуль бойынша өңдеу

Ескі All in One SEO плагині роботтардың txt файлын өзгерте алады, бұл мүмкіндікті белсендіру үшін модульдер бөліміне өтіп, аттас элементті тауып, Белсендіру түймесін басыңыз.

Барлығы бір SEO жүйесіндегі модульдер

Барлығы бір SEO жүйесіндегі модульдер Мәзірде All in One SEO пайда болады жаңа бөлім, біз кіреміз, біз конструктордың функционалдығын көреміз.

AIOS модулінде жұмыс істеу

AIOS модулінде жұмыс істеу - Біз агенттің атын жазамыз, біздің жағдайда * немесе оны бос қалдырамыз

- Индекстеуге рұқсат беру немесе өшіру

- Баруға болмайтын каталог немесе бет

- Нәтиже

Модуль ыңғайлы емес, осы принцип бойынша жарамды және дұрыс robots.txt құру қиын. Басқа құралдарды қолданған дұрыс.

WooCommerce плагинін дұрыс орнату

WordPress WooCommerce электрондық коммерция плагинін дұрыс орнату үшін қалғандарына мына жолдарды қосыңыз:

Рұқсат етпеу: /арба/ Рұқсат етпеу: /тексеру/ Рұқсат етпеу: /*себетке қосу=*

Біз ұқсас әрекеттерді орындаймыз және серверге FTP немесе плагин арқылы жүктейміз.

Нәтиже

WordPress сайтында іздеу жүйелері үшін дұрыс файл болуы үшін не істеу керектігін қорытындылайық:

- Файлды қолмен немесе плагин арқылы жасаңыз

- Біз оған мақаланың нұсқауларын жазамыз

- Серверге жүктеп салу

- Яндекс валидаторында тексерілуде

- Интернетте роботтардың txt генераторларын қолданбаңыз, қолыңызды аздап жылжытыңыз

WordPress блогтарыңызды жетілдіріңіз, алға жылжыңыз және барлық параметрлерді дұрыс орнатыңыз, біз сізге көмектесеміз, сәттілік!

Автордан:сайтыңызды индекстеу кезінде іздеу жүйелері пайдаланатын файлдардың бірі robots.txt файлы болып табылады. Файлдың атауынан оның роботтар үшін қолданылатынын түсіну қиын емес. Шынында да, бұл файл іздеу роботына сайтта нені индекстеуге болатынын және нені көргіңіз келмейтінін айтуға мүмкіндік береді. іздеу индексі. Сонымен, WordPress сайты үшін robots txt файлын қалай орнату керектігін көрейік.

Бұл тақырып бойынша Интернетте көптеген мақалалар бар. Осы мақалалардың әрқайсысында сіз WordPress сайтында өңдеусіз дерлік қабылдауға және пайдалануға болатын robots txt файлының жеке нұсқасын таба аласыз. Мен осы мақалада осы опциялардың бірін қайта жазбаймын, өйткені бұл жерде көп нәрсе жоқ - сіз осы опциялардың барлығын желіден оңай таба аласыз. Сол мақалада біз WordPress үшін роботтардың txt файлын қалай жасау керектігін және онда қандай минималды ережелер болуы керек екенін талдаймыз.

Robots.txt файлы қайда орналасу керек және оған не жазу керек екенін бастайық. Бұл файл, sitemap.xml файлы сияқты сайтыңыздың түбірінде орналасуы керек, яғни. ол http://site/robots.txt мекенжайында қолжетімді болуы керек

Сайт сөзін өз сайтыңыздың мекенжайымен ауыстырып, осы мекенжайға хабарласып көріңіз. Мынадай нәрсені мына жерден көре аласыз:

Сіз бұл суретті көре аласыз:

Біртүрлі жағдай, айтасыз. Шынында да, мекенжай бірдей, бірақ бірінші жағдайда файл қол жетімді, екіншісінде ол жоқ. Сонымен қатар, сайттың түбірін қарасаңыз, ол жерден robots.txt файлын таба алмайсыз. WordPress-те robots.txt қалай және қайда орналасқан?

Мұның бәрі қарапайым орнату туралы - бұл CNC орнату. Егер сайтыңызда CNC қосылған болса, қозғалтқыш динамикалық түрде жасалған robots.txt файлын көресіз. В әйтпесе 404 қатесі қайтарылады.

«Параметрлер - Тұрақты сілтемелер» мәзірінде «Пост атауы» параметрін тексеріп, CNC қосыңыз. Өзгерістерді сақтаңыз - енді robots.txt файлы қозғалтқышпен динамикалық түрде жасалады.

Бірінші суретте көріп отырғаныңыздай, бұл файл белгілі бір ережелерді орнататын кейбір директиваларды пайдаланады, атап айтқанда, берілген мекенжайда бір нәрсені индекстеуге рұқсат беру немесе тыйым салу. Сіз болжағандай, рұқсат бермеу директивасы индекстеуді өшіреді. Бұл жағдайда, бұл wp-admin қалтасының толық мазмұны. Ал, Allow директивасы индекстеуге мүмкіндік береді. Менің жағдайда, admin-ajax.php файлын жоғарыда тыйым салынған wp-admin қалтасынан индекстеу рұқсат етілген.

Жалпы, бұл файл, әрине, іздеу жүйелері үшін қажет емес, мен WordPress бұл ережені не үшін жазғанын елестете де алмаймын. Иә, мен өкінбеймін, негізі

Айтпақшы, мен жоғарыда «менің жағдайымда» деген сөз тіркесін арнайы қостым, өйткені сіздің жағдайда robots.txt мазмұны басқаша болуы мүмкін. Мысалы, оны индекстеуге тыйым салынуы мүмкін wp-қапшықты қамтиды.

Robots.txt ішіндегі Allow және Allow директиваларымен қатар, біз жұлдызша мән ретінде көрсетілген User-агент директивасын көреміз. Жұлдызша келесі ережелер жиынтығы барлық іздеу жүйелеріне қолданылатынын білдіреді. Сондай-ақ жұлдызшаның орнына арнайы іздеу жүйелерінің атауларын көрсетуге болады. robots.txt файлы басқа директиваларды да қолдайды. Мен оларға тоқталмаймын, олардың барлығын мысалдармен Google немесе Yandex веб-шеберінің консолінде көруге болады. Сондай-ақ ақпаратты осы сайттан оқи аласыз.

Wordpress үшін роботтар txt қалай жасауға болады

Сонымен, бізде іздеу роботтарына арналған файл бар, бірақ ол қазіргі күйінде сізге сәйкес келмеуі мүмкін. Өз файлыңызды қалай жасауға болады. Мұнда бірнеше нұсқа бар. Біріншіден бастайық - файлды қолмен жасау. Қалыпты жасаңыз Мәтіндік құжатблокнотта және оны .txt кеңейтімі бар роботтар ретінде сақтаңыз. Бұл файлға жазыңыз қажетті жиынтықережелерін анықтап, оны жай ғана WordPress сайтыңыздың түбірінде, wp-config.php конфигурация файлының жанында сақтаңыз.

Кез келген жағдайда, файлдың жүктелгенін және оған шолғыштан қол жеткізу арқылы қол жетімді екенін тексеріңіз. Бұл бірінші жол болды. Екінші әдіс - бірдей динамикалық файлды генерациялау, тек енді оны плагин жасайды. Егер сіз танымал All in One SEO плагинін пайдалансаңыз, оның модульдерінің бірін пайдалануға болады.

Бұл мақала сайттарыңызда пайдалануға болатын WordPress robots.txt файлына арналған ең жақсы кодтың мысалы болып табылады.

Алдымен, еске түсірейік robots.txt не үшін қажет- robots.txt файлы тек іздеу роботтарына сайттың қай бөлімдеріне/беттеріне кіру керектігін және қайсысына барудың қажеті жоқ екенін «айту» үшін қажет. Кіруден жабылған беттер іздеу жүйелерімен (Яндекс, Google және т.б.) индекстелмейді.

1-нұсқа: WordPress үшін оңтайлы robots.txt коды

Пайдаланушы-агент: * Рұқсат етпеу: /cgi-bin # classic... Рұқсат етпеу: /? # басты беттегі барлық сұрау опциялары Рұқсат етілмейді: /wp- # барлық WP файлдары: /wp-json/, /wp-includes, /wp-content/plugins Рұқсат етілмейді: *?s= # іздеу Рұқсат етілмейді: *&s= # іздеу Рұқсат ету: /іздеу # іздеу Рұқсат ету: /автор/ # автор мұрағаты Рұқсат ету: */енгізу # all ендірілгендер Рұқсат ету: */бет/ # беттеудің барлық түрлері Рұқсат ету: */жүктеп салу # жүктеп салуды ашу Рұқсат ету: /*/*.js # ішінде /wp - (/*/ - басымдық үшін) Рұқсат ету: /*/*.css # ішінде /wp- (/*/ - басымдық үшін) Рұқсат ету: /wp-*.png # плагиндердегі, кэш қалтасындағы және т.б. . Рұқсат етіңіз: /wp-*.jpg # плагиндердегі кескіндер, кэш қалтасы, т.б. Рұқсат етіңіз: /wp-*.jpeg # плагиндердегі кескіндер, кэш қалтасы, т.б. Рұқсат етіңіз: /wp-*.gif # плагиндердегі суреттер, кэш қалтасы, т.б. Рұқсат етіңіз: /wp-*.svg # плагиндердегі кескіндер, кэш қалтасы, т.б. Рұқсат етіңіз: /wp-*.pdf # плагиндердегі файлдар, кэш қалтасы, т.б. Рұқсат ету: /wp-admin/admin-ajax.php #Қолданбау: /wp/ # WP wp ішкі каталогында орнатылғанда Сайт картасы: http://example.com/sitemap.xml Сайт картасы: http://example.com/sitemap2 xml # басқа файл #Сайт картасы: http://example.com/sitemap.xml.gz # қысылған нұсқа (.gz) # Код нұсқасы: 1.1 # Сайтыңызға `site.ru` өзгертуді ұмытпаңыз.Кодты талдау:

- Рұқсат етпеу: /cgi-bin - сервердегі сценарий каталогын жабады

- Рұқсат етпеу: /арна - блогтың RSS арнасын жабады

- Тығыздамау: /trackback - хабарландыруларды өшіру

- Рұқсат етпеу: ?s= немесе рұқсат бермеу: *?s= - іздеу беттерін жабу

- Allow: */page/ - беттеудің барлық түрлерін жабады

Сайт картасы ережесі: http://example.com/sitemap.xml роботты XML сайт картасы файлына көрсетеді. Егер сіздің сайтыңызда осындай файл болса, оған толық жолды жазыңыз. Мұндай файлдар бірнеше болуы мүмкін, содан кейін әрқайсысына жолды бөлек көрсетеміз.

Host: site.ru жолында біз сайттың негізгі айнасын көрсетеміз. Егер сайтта айналар болса (басқа домендердегі сайттың көшірмелері), онда Яндекс олардың барлығын бірдей индекстеу үшін негізгі айнаны көрсету керек. Директивалық хост: тек Яндексті түсінеді, Google түсінбейді! Егер сайт https протоколы бойынша жұмыс істесе, онда ол Хостта көрсетілуі керек: Хост: http://example.com

Яндекс құжаттамасынан: «Хост тәуелсіз директива болып табылады және файлдың кез келген жерінде жұмыс істейді (көлденең қима)». Сондықтан біз оны бос жол арқылы файлдың жоғарғы жағына немесе ең соңына қоямыз.

User-агент: * жолында біз келесі ережелердің барлығы барлық тексеріп шығушылар үшін жұмыс істейтінін көрсетеміз * . Бұл ережелер тек бір нақты робот үшін жұмыс істеуін қаласаңыз, * орнына роботтың атын көрсетіңіз (Пайдаланушы-агент: Yandex , Пайдаланушы-агент: Googlebot).

Рұқсат ету: */жүктеп салулар жолында біз /жүктеп салулар бар беттерге индекстелуге әдейі рұқсат береміз. Бұл ереже міндетті, өйткені жоғарыда біз /wp- және әріптерінен басталатын беттерді индекстеуге тыйым саламыз /wp-кіреді /wp-content/loads. Сондықтан, рұқсат бермеу: /wp- ережесін бұзу үшін сізге Allow: */uploads жолы қажет, себебі сияқты сілтемелерде /wp-content/uploads/...бізде индекстелетін суреттер болуы мүмкін, сондай-ақ жасырудың қажеті жоқ кейбір жүктелген файлдар болуы мүмкін. Рұқсат ету: «бұрын» немесе «кейін» болуы мүмкін Рұқсат етпеу: .

Қалған жолдар роботтардың келесіден басталатын сілтемелер бойынша «жүруіне» жол бермейді:

Ашық арналардың болуы қажет болғандықтан, мысалы, Yandex Zen үшін сайтты арнаға қосу қажет болғанда (сандық комментатордың арқасында). Ашық арналар басқа жерде қажет болуы мүмкін.

Сонымен қатар, арналардың жауап тақырыптарында өз пішімі бар, соның арқасында іздеу жүйелері бұл емес екенін түсінеді. HTML беті, ал арна және анық оны басқаша өңдейді.

Яндекс үшін хост директивасы енді қажет емес

Яндекс Хост директивасын толығымен тастайды, ол 301 қайта бағыттаумен ауыстырылды. Хостты robots.txt файлынан қауіпсіз жоюға болады. Дегенмен, барлық сайт айналарында негізгі сайтқа (негізгі айна) 301 қайта бағыттау болуы маңызды.

Бұл маңызды: өңдеу алдында ережелерді сұрыптау

Яндекс пен Google Рұқсат ету және тыйым салу директивасын олар көрсетілген ретпен өңдемейді, бірақ алдымен оларды қысқа ережеден ұзынға дейін сұрыптайды, содан кейін соңғы сәйкес ережені өңдейді:

Пайдаланушы-агент: * Рұқсат ету: */жүктеп салулар Рұқсат етпеу: /wp-

былай оқылады:

Пайдаланушы-агент: * Рұқсат ету: /wp- Рұқсат ету: */жүктеп салулар

Сұрыптау мүмкіндігін жылдам түсіну және қолдану үшін мына ережені есте сақтаңыз: «robots.txt файлындағы ереже неғұрлым ұзақ болса, соғұрлым оның басымдығы болады. Ережелердің ұзақтығы бірдей болса, рұқсат беру директивасы басымдыққа ие болады».

2-нұсқа: WordPress үшін стандартты robots.txt

Мен ешкімді білмеймін, бірақ мен бірінші нұсқаны жақтаймын! Бұл қисындырақ болғандықтан - көлденең қимасы бар Yandex үшін хост директивасын көрсету үшін бөлімді толығымен көшірудің қажеті жоқ (оны робот үлгінің кез келген жерінде түсінеді, қай роботқа сілтеме жасайтынын көрсетпей-ақ). . Стандартты емес директиваға келетін болсақ, рұқсат беру , ол Яндекс пен Google үшін жұмыс істейді және егер ол оны түсінбейтін басқа роботтар үшін жүктеп салулар қалтасын ашпаса, 99% бұл қауіпті ештеңеге әкелмейді. Мен бірінші роботтардың дұрыс жұмыс істемейтінін әлі байқамадым.

Жоғарыдағы код сәл дұрыс емес. Түсініктеме берушіге «» қатені көрсеткеніңіз үшін рахмет, бірақ мен оның не екенін өзім анықтауға тура келді. Міне, мен ойлап таптым (қате болуы мүмкін):

- Yandex директивасы Хост: рұқсат бермеуден кейін пайдаланылуы керек: себебі кейбір роботтар (Яндекс пен Google емес) оны түсінбеуі және robots.txt файлын қабылдамауы мүмкін. Құжаттамаға сүйенсек, сайттың барлық айналарын желімдеу үшін Хост: www.site.ru бір ғана жолымен robots.txt файлын жасасаңыз да, Яндекстің өзі Host: қай жерде және қалай пайдаланатыны маңызды емес.

Кейбір роботтар (Яндекс пен Google емес) 2 директивадан артық түсінбейді: User-агент: және рұқсат бермеу:

3. Сайт картасы: Яндекс пен Google және көптеген басқа роботтар үшін көлденең қима директивасы, сондықтан біз оны соңында бос жол арқылы жазамыз және ол бірден барлық роботтар үшін жұмыс істейді.

Осы түзетулердің негізінде дұрыс код келесідей болуы керек:

Пайдаланушы-агент: Яндекс Рұқсат етпеу: /wp-admin Тыйым салу: /wp-includes Рұқсат ету: /wp-content/plugins Рұқсат ету: /wp-json/ Рұқсат етпеу: /wp-login.php Рұқсат етпеу: /wp-register.php Рұқсат етпеу: */embed Рұқсат ету: */page/ Рұқсат ету: /cgi-bin Рұқсат ету: *?s= Рұқсат ету: /wp-admin/admin-ajax.php Хост: site.ru Пайдаланушы-агент: * Рұқсат етпеу: /wp-admin Рұқсат ету : /wp-includes Рұқсат етпеу: /wp-content/plugins Рұқсат етпеу: /wp-json/ Рұқсат етпеу: /wp-login.php Рұқсат ету: /wp-register.php Тыйым салу: */embed Рұқсат етпеу: */page/ Рұқсат етпеу: / cgi-bin Рұқсат ету: *?s= Рұқсат ету: /wp-admin/admin-ajax.php Сайт картасы: http://example.com/sitemap.xmlБіз өзіміз үшін қосамыз

Басқа беттерге немесе беттер тобына тыйым салу қажет болса, төменде ереже (директива) қосуға болады. Рұқсат етпеу:. Мысалы, санаттағы барлық хабарламаларды индекстеуден жабу керек жаңалықтар, содан кейін бұрын сайт картасы:ережені қосыңыз:

Рұқсат етпеу: /жаңалықтар

Ол роботтардың келесі сілтемелерге кіруіне жол бермейді:

- http://example.com/news

- http://example.com/news/drugoe-name/

Егер сізге /news оқиғаларын жабу қажет болса, біз жазамыз:

Рұқсат етпеу: */news

- http://example.com/news

- http://example.com/my/news/drugoe-name/

- http://example.com/category/newsletter-name.html

Robots.txt директивалары туралы толығырақ Яндекс анықтама бетінде білуге болады (бірақ онда сипатталған барлық ережелер Google үшін жұмыс істемейтінін есте сақтаңыз).

Robots.txt тексеру және құжаттама

Белгіленген ережелердің дұрыс жұмыс істеп тұрғанын келесі сілтемелер арқылы тексеруге болады:

- Яндекс: http://webmaster.yandex.ru/robots.xml .

- Google-де бұл орындалады іздеу консолі. Сізге авторизация және веб-шебер панелінде сайттың болуы қажет...

- robots.txt файлын құру қызметі: http://pr-cy.ru/robots/

- robots.txt файлын құру және тексеру қызметі: https://seolib.ru/tools/generate/robots/

Мен Яндекс сұрадым...

Солардың ішінде сұрақ қойды. Хост пен Сайт картасы директиваларын көлденең пайдалану үшін Yandex қолдауы:

Сұрақ:

Сәлеметсіз бе!

Мен блогымда robots.txt туралы мақала жазып жатырмын. Мен осындай сұраққа жауап алғым келеді (құжаттамада бір мағыналы «иә» таппадым):Егер мен барлық айналарды желімдеу керек болса және ол үшін мен robots.txt файлының ең басында Host директивасын қолданамын:

Хост: site.ru Пайдаланушы-агент: * Рұқсат етпеу: /asd

Ол болады ма бұл мысалдұрыс жұмыс Хост: site.ru? Бұл роботтарға site.ru негізгі айна екенін көрсетеді ме? Анау. Мен бұл директиваны бөлімде емес, бөлек (файлдың басында) қай User-агентке сілтеме жасайтынын көрсетпей қолданамын.

Мен сондай-ақ Сайт картасы директивасын бөлімнің ішінде пайдалану керек пе, әлде оны сыртында қолдануға бола ма, жоқ па, соны білгім келді: мысалы, бос жол арқылы, бөлімнен кейін?

Пайдаланушы-агент: Яндекс тыйым салу: /asd Пайдаланушы-агент: * Рұқсат етпеу: /asd Сайт картасы: http://example.com/sitemap.xml

Робот осы мысалдағы Сайт картасы директивасын түсінеді ме?

Сізден менің күмәніме нүкте қоятын жауап аламын деп үміттенемін.

Жауап:

Сәлеметсіз бе!

Хост және Сайт картасы директивалары көлденең қима болып табылады, сондықтан оларды robots.txt файлында қай жерде көрсетілгеніне қарамастан робот пайдаланады.

--

Құрметпен, Платон Щукин

Яндекс қолдауы

Қорытынды

Жұмыс істеп тұрған сайттағы robots.txt өзгертулері тек бірнеше айдан кейін (2-3 ай) байқалатынын есте ұстаған жөн.

Google кейде robots.txt файлындағы ережелерді елемей, бетті өте бірегей және пайдалы деп есептесе және индексте болуы керек деп есептесе, оны индекске енгізе алады деген қауесет бар. Дегенмен, басқа қауесеттер тәжірибесіз оңтайландырушылар robots.txt файлындағы ережелерді қате көрсетіп, оны осылай жауып тастауы мүмкін деп, бұл гипотезаны жоққа шығарады. қалаған беттериндекстеуден және қажетсіздерін қалдырыңыз. Мен екінші ұсынысқа көбірек бейіммін ...

Dynamic robots.txt

WordPress-те robots.txt файлына сұраныс бөлек өңделеді және сайттың түбірінде robots.txt файлын физикалық түрде жасау қажет емес, сонымен қатар бұл ұсынылмайды, өйткені бұл тәсілмен бұл өте қиын болады. плагиндер үшін бұл файлды өзгерту үшін және бұл кейде қажет.

Функцияның сипаттамасында robots.txt файлын динамикалық құру қалай жұмыс істейтіні туралы оқыңыз және төменде мен бұл файлдың мазмұнын ілмек арқылы жылдам өзгертуге болатынын мысал келтіремін.

Мұны істеу үшін functions.php файлыңызға келесі кодты қосыңыз:

Add_action("do_robotstxt", "my_robotstxt"); function my_robotstxt()( $lines = [ "Пайдаланушы-агент: *", "Рұқсат етпеу: /wp-admin/", "Рұқсат етпеу: /wp-includes/", "", ]; echo implode("\r\n ", $lines); өлу; // PHP тоқтату )

Пайдаланушы-агент: * Рұқсат етпеу: /wp-admin/ Рұқсат етпеу: /wp-includes/

Crawl-кешіктіру - ақылсыз роботтар үшін күту уақыты (2018 жылдан бері есепке алынбайды)

Яндекс

Индекстеу қолдауымызға соңғы екі жылдағы электрондық хаттарды талдағаннан кейін біз құжаттарды баяу жүктеп алудың негізгі себептерінің бірі robots.txt файлындағы қате конфигурацияланған Crawl-delay директивасы екенін білдік [...] Сайт иелерінде бұл туралы енді алаңдау үшін және сайттардың барлық шын мәнінде қажетті беттері іздеуде пайда болуы және тез жаңартылуы үшін біз Crawl-delay директивасын ескеруден бас тартуды шештік.

Яндекс роботы сайтты жынды сияқты тексергенде және бұл серверде қажетсіз жүктемені жасайды. Роботтан «баяулауды» сұрауға болады.

Ол үшін Crawl-delay директивасын пайдалану керек. Ол роботтың сайттың әрбір келесі бетін қарап шығу үшін бос тұру (күту) уақытын секундтармен көрсетеді.

Robots.txt стандартына бағынбайтын роботтармен үйлесімділік үшін Тексеру кешігуі Топта (Пайдаланушы-Агент бөлімінде) рұқсат бермеу және Рұқсат етуден кейін бірден көрсетілуі керек.

Яндекс роботы бөлшек мәндерді түсінеді, мысалы, 0,5 (жарты секунд). Бұл тексеріп шығушы сіздің сайтыңызға жарты секунд сайын кіретініне кепілдік бермейді, бірақ бұл сайтты тексеруді тездетуге мүмкіндік береді.

Пайдаланушы-агент: Яндекс Рұқсат ету: /wp-admin Рұқсат ету: /wp-қосады Тексеру кідірісі: 1,5 # 1,5 секунд күту уақыты Пайдаланушы агенті: * Рұқсат етпеу: /wp-admin Рұқсат ету: /wp-қосады Рұқсат ету: /wp-* . gif Тексеру кідірісі: 2 секундтан 2 # күту уақыты

Googlebot Crawl-delay директивасын түсінбейді. Оның роботтары үшін күту уақытын веб-шебердің панелінде көрсетуге болады.

avi1.ru сервисінде сіз қазірдің өзінде сатып ала аласыз SMM жарнамасы 7-ден астам ең танымал әлеуметтік желілерде. Сонымен қатар, жеткілікті назар аударыңыз төмен бағабарлық сайт қызметтері.