Encyklopedia Informatyki. Wielka radziecka encyklopedia - informatyka

W krajach anglojęzycznych używany jest termin informatyka - informatyka.

Teoretyczne podstawy informatyki to grupa nauk podstawowych takich jak: teoria informacji, teoria algorytmów, logika matematyczna, teoria języków formalnych i gramatyk, analiza kombinatoryczna itp. Oprócz nich informatyka obejmuje takie działy jak architektura komputerów, systemy operacyjne, teoria baz danych, technologia programowania i wiele innych. Ważne przy definiowaniu informatyki jako nauki jest to, że z jednej strony zajmuje się ona badaniem urządzeń i zasad działania techniki komputerowej, a z drugiej usystematyzowaniem technik i metod pracy z programami, które kontrolować tę technologię.

Technologia informatyczna to zbiór określonych informacji technicznych i narzędzia programowe, które wykonują różne operacje na przetwarzanie informacji we wszystkich sferach naszego życia i działalności. Technologia informacyjna jest czasami określana jako technologia komputerowa lub informatyka stosowana.

Informacje analogowe i cyfrowe.

Termin „informacja” pochodzi z łacińskiego informatio, – wyjaśnienie, ekspozycja, świadomość.

Informacje można sklasyfikować różne sposoby, a różne nauki robią to na różne sposoby. Na przykład w filozofii rozróżnia się informacje obiektywne i subiektywne. Obiektywne informacje odzwierciedlają zjawiska przyrody i społeczeństwa ludzkiego. Informacje subiektywne są tworzone przez ludzi i odzwierciedlają ich pogląd na obiektywne zjawiska.

W informatyce informacje analogowe i informacje cyfrowe są rozpatrywane oddzielnie. To ważne, bo człowiek dzięki swoim zmysłom jest przyzwyczajony do obcowania z informacją analogową, podczas gdy technika komputerowa przeciwnie, pracuje głównie z informacją cyfrową.

Osoba odbiera informacje za pomocą zmysłów. Światło, dźwięk, ciepło są sygnałami energetycznymi, a smak i zapach są wynikiem narażenia na związki chemiczne, które również są oparte na naturze energetycznej. Osoba doświadcza ciągłych oddziaływań energii i może nigdy nie spotkać się z tą samą ich kombinacją dwa razy. Nie ma dwóch identycznych zielonych liści na jednym drzewie i dwóch absolutnie identycznych dźwięków – to informacja analogowa. Jeśli podano liczby w różnych kolorach, oraz różne dźwięki- notatki, a następnie informacje analogowe można zamienić na cyfrowe.

Słuchana muzyka niesie ze sobą informacje analogowe, ale gdy jest notowana, staje się cyfrowa.

Różnica między informacją analogową a informacją cyfrową polega przede wszystkim na tym, że informacja analogowa jest ciągła, podczas gdy informacja cyfrowa jest dyskretna.

Urządzeniami cyfrowymi są komputery osobiste – pracują z informacjami przedstawionymi w postaci cyfrowej, a cyfrowe są również odtwarzacze muzyki z laserowych płyt kompaktowych.

Kodowanie informacji.

Kodowanie informacji to proces tworzenia określonej reprezentacji informacji. .

W węższym znaczeniu termin „kodowanie” jest często rozumiany jako przejście od jednej formy prezentacji informacji do innej, wygodniejszej do przechowywania, przesyłania lub przetwarzania.

Komputer może przetwarzać tylko informacje przedstawione w postaci liczbowej. Wszystkie inne informacje (dźwięki, obrazy, odczyty instrumentów itp.) należy przekonwertować do postaci liczbowej w celu przetworzenia na komputerze. Na przykład, aby określić ilościowo dźwięk muzyczny, można zmierzyć natężenie dźwięku przy określonych częstotliwościach w krótkich odstępach czasu, przedstawiając wyniki każdego pomiaru w postaci liczbowej. Przez programy komputerowe możesz przekształcić otrzymane informacje, na przykład „nałożyć” dźwięki z różnych źródeł jeden na drugi.

Podobnie informacje tekstowe mogą być przetwarzane na komputerze. Po wprowadzeniu do komputera, każda litera jest kodowana przez określoną liczbę, a po wyprowadzeniu do urządzenia zewnętrzne(sitodruk lub wydruk) dla ludzkiej percepcji obrazy liter są budowane na tych liczbach. Korespondencja między zestawem liter i cyfr nazywana jest kodowaniem znaków.

Z reguły wszystkie liczby w komputerze są reprezentowane za pomocą zer i jedynek (a nie dziesięciu cyfr, jak to jest w zwyczaju dla ludzi). Innymi słowy, komputery zwykle działają w trybie binarnym system liczbowy, ponieważ w tym przypadku urządzenia do ich przetwarzania są znacznie prostsze.

Jednostki miary informacji. Fragment. Bajt.

Bit to najmniejsza jednostka reprezentacji informacji. Bajt - najmniejsza jednostka przetwarzania i przesyłania informacji .

Rozwiązując różne problemy, człowiek wykorzystuje informacje o otaczającym nas świecie. Często słyszy się, że wiadomość niesie ze sobą niewiele informacji lub odwrotnie, zawiera informacje wyczerpujące, podczas gdy różne osoby, które otrzymują tę samą wiadomość (na przykład po przeczytaniu artykułu w gazecie), różnie oceniają ilość zawartych w nim informacji. Oznacza to, że wiedza ludzi o tych wydarzeniach (zjawiskach) przed otrzymaniem wiadomości była inna. Ilość informacji w wiadomości zależy więc od tego, jak nowa jest wiadomość dla odbiorcy. Jeżeli w wyniku odebrania komunikatu uzyskano pełną jasność w danej kwestii (czyli zniknęła niepewność), mówią, że otrzymali wyczerpujące informacje. Oznacza to, że nie ma potrzeby podawania dodatkowych informacji na ten temat. Wręcz przeciwnie, jeśli po otrzymaniu wiadomości niepewność pozostała taka sama (przekazywana informacja była już znana lub nieistotna), to nie otrzymano żadnej informacji (informacja zerowa).

Rzucanie monetą i patrzenie, jak spada, dostarcza pewnych informacji. Obie strony medalu są „równe”, więc obie strony mają jednakowe szanse na wyłonienie. W takich przypadkach mówi się, że zdarzenie przenosi informacje w 1 bitzie. Jeśli włożymy do woreczka dwie kulki w różnych kolorach, to rysując na ślepo jedną kulkę, w 1 bicie uzyskamy również informację o kolorze kulki.

Jednostką miary informacji jest bit (bit) - skrót od angielskich słów cyfra binarna, co oznacza cyfra binarna.

W technice komputerowej bit odpowiada fizycznemu stanowi nośnika informacji: namagnesowany - nienamagnesowany, jest dziura - dziury nie ma. W takim przypadku jeden stan jest zwykle oznaczany cyfrą 0, a drugi liczbą 1. Wybór jednej z dwóch możliwych opcji pozwala również odróżnić logiczną prawdę od fałszu. Sekwencja bitów może kodować tekst, obraz, dźwięk lub dowolną inną informację. Ta metoda przedstawiania informacji nazywana jest kodowaniem binarnym. (kodowanie binarne) .

W informatyce często używa się wielkości zwanej bajtem i jest ona równa 8 bitom. A jeśli bit pozwala wybrać jedną opcję z dwóch możliwych, to odpowiednio bajt wynosi 1 z 256 (2 8). Wraz z bajtami do pomiaru ilości informacji używane są większe jednostki:

1 KB (jeden kilobajt) = 2\up1210 bajtów = 1024 bajty;

1 MB (jeden megabajt) = 2\up1210 KB = 1024 KB;

1 GB (jeden gigabajt) = 2\up1210 MB = 1024 MB.

Na przykład książka zawiera 100 stron; 35 linii na stronę, 50 znaków na linię. Objętość informacji zawartych w księdze oblicza się w następujący sposób:

Strona zawiera 35 × 50 = 1750 bajtów informacji. Objętość wszystkich informacji w księdze (w różnych jednostkach):

1750 × 100 = 175 000 bajtów.

175 000/1024 = 170,8984 KB.

170,8984 / 1024 = 0,166893 MB.

Plik. Formaty plików.

Plik to najmniejsza jednostka przechowywania informacji, która zawiera sekwencję bajtów i ma unikalną nazwę.

Głównym celem plików jest przechowywanie informacji. Przeznaczone są również do przesyłania danych z programu do programu iz systemu do systemu. Innymi słowy, plik jest repozytorium stabilnych i mobilnych danych. Ale plik to coś więcej niż magazyn danych. Plik zwykle zawiera nazwa, atrybuty, czas modyfikacji i czas utworzenia.

Struktura plików to system przechowywania plików na urządzeniu pamięci masowej, takim jak dysk. Pliki są zorganizowane w katalogi (czasami nazywane katalogami lub folderami). Każdy katalog może zawierać dowolną liczbę podkatalogów, z których każdy może przechowywać pliki i inne katalogi.

Sposób, w jaki dane są zorganizowane w bajty, nazywa się formatem pliku. .

Aby odczytać plik, taki jak arkusz kalkulacyjny, musisz wiedzieć, jak bajty reprezentują liczby (wzory, tekst) w każdej komórce; aby odczytać plik edytora tekstu, trzeba wiedzieć, które bajty reprezentują znaki, a jakie czcionki lub pola oraz inne informacje.

Programy mogą przechowywać dane w pliku w sposób wybrany przez programistę. Często jednak oczekuje się, że pliki będą używane przez różne programy, dlatego wiele aplikacji obsługuje niektóre z bardziej popularnych formatów, aby inne programy mogły zrozumieć dane w pliku. Firmy programistyczne (które chcą, aby ich programy stały się „standardami”) często publikują informacje o tworzonych przez siebie formatach, aby można je było wykorzystać w innych aplikacjach.

Wszystkie pliki można warunkowo podzielić na dwie części - tekstową i binarną.

Pliki tekstowe są najczęstszym typem danych w świecie komputerów. Najczęściej jeden bajt jest przeznaczony do przechowywania każdego znaku, a pliki tekstowe są kodowane za pomocą specjalnych tabel, w których każdy znak odpowiada określonej liczbie nieprzekraczającej 255. Plik do kodowania, który wykorzystuje tylko 127 pierwszych liczb, jest nazywany ASCII- file (skrót od American Standard Code for Information Intercange - amerykański standardowy kod wymiany informacji), ale taki plik nie może zawierać liter innych niż łacińskie (w tym rosyjskie). Większość alfabetów narodowych można zakodować przy użyciu tabeli ośmiobitowej. W przypadku języka rosyjskiego obecnie najpopularniejsze są trzy kodowania: Koi8-R, Windows-1251 oraz tzw. kodowanie alternatywne (alt).

Języki takie jak chiński zawierają znacznie więcej niż 256 znaków, więc do kodowania każdego znaku używa się wielu bajtów. Aby zaoszczędzić miejsce, często stosuje się następującą sztuczkę: niektóre znaki są kodowane przy użyciu jednego bajtu, podczas gdy inne używają dwóch lub więcej bajtów. Jedną z prób uogólnienia tego podejścia jest standard Unicode, który używa do kodowania znaków zakresu liczb od zera do 65 536. Tak szeroki zakres pozwala na numeryczne reprezentowanie znaków języka z dowolnego zakątka planety.

Ale czyste pliki tekstowe stają się coraz rzadsze. Dokumenty często zawierają zdjęcia i diagramy, a używane są różne czcionki. W rezultacie pojawiają się formaty będące różnymi kombinacjami danych tekstowych, graficznych i innych.

Pliki binarne, w przeciwieństwie do plików tekstowych, nie są tak łatwe do przeglądania i zwykle nie zawierają znanych słów - tylko wiele niejasnych znaków. Pliki te nie są przeznaczone do bezpośredniego odczytu przez ludzi. Przykładami plików binarnych są programy wykonywalne i pliki graficzne.

Przykłady binarnego kodowania informacji.

Wśród różnorodnych informacji przetwarzanych na komputerze znaczącą część stanowią informacje numeryczne, tekstowe, graficzne i dźwiękowe. Zapoznajmy się z niektórymi sposobami kodowania tego typu informacji w komputerze.

Kodowanie liczb.

Istnieją dwa główne formaty przedstawiania liczb w pamięci komputera. Jedna z nich służy do kodowania liczb całkowitych, druga (tzw. zmiennoprzecinkowa reprezentacja liczby) służy do określenia pewnego podzbioru liczb rzeczywistych.

Zbiór liczb całkowitych, które mogą być reprezentowane w pamięci komputera, jest ograniczony. Zakres wartości zależy od wielkości obszaru pamięci używanego do przechowywania liczb. W k-bit komórka może przechowywać 2 k różne wartości liczb całkowitych .

Aby uzyskać wewnętrzną reprezentację dodatniej liczby całkowitej n przechowywane w k-bitowe słowo maszynowe, potrzebujesz:

1) przetłumacz liczbę N na system liczb binarnych;

2) otrzymany wynik uzupełnia się z lewej strony nieznaczącymi zerami do k cyfr.

Na przykład, aby uzyskać wewnętrzną reprezentację liczby całkowitej 1607 w 2-bajtowej komórce, liczba jest konwertowana na binarną: 1607 10 = 11001000111 2 . Wewnętrzna reprezentacja tej liczby w komórce to: 0000 0110 0100 0111.

Aby napisać wewnętrzną reprezentację ujemnej liczby całkowitej (–N), potrzebujesz:

1) uzyskaj wewnętrzną reprezentację liczby dodatniej n;

2) uzyskać kod zwrotny tego numeru, zastępując 0 na 1 i 1 na 0;

3) dodać 1 do otrzymanej liczby.

Wewnętrzna reprezentacja ujemnej liczby całkowitej to -1607. Korzystając z wyniku z poprzedniego przykładu, zapisujemy wewnętrzną reprezentację liczby dodatniej 1607: 0000 0110 0100 0111. Odwrotny kod otrzymujemy przez odwrócenie: 1111 1001 1011 1000. Dodawane jest jedno: 1111 1001 1011 1001 - to jest wewnętrzny binarna reprezentacja liczby -1607.

Format zmiennoprzecinkowy wykorzystuje reprezentację liczb rzeczywistych r jako produkt mantysy m na podstawie systemu liczbowego n do pewnego stopnia P, który nazywa się zamówieniem: R=m * np.

Reprezentacja liczby w postaci zmiennoprzecinkowej jest niejednoznaczna. Na przykład prawdziwe są następujące równości:

12,345 \u003d 0,0012345 × 10 4 \u003d 1234,5 × 10 -2 \u003d 0,12345 × 10 2

Najczęściej komputery używają znormalizowanej reprezentacji liczby w postaci zmiennoprzecinkowej. Mantysa w tym przedstawieniu musi spełniać warunek:

0,1 pJ m P . Innymi słowy, mantysa jest mniejsza niż 1, a pierwsza cyfra znacząca nie jest równa zero ( P jest podstawą systemu liczbowego).

W pamięci komputera mantysa jest reprezentowana jako liczba całkowita zawierająca tylko cyfry znaczące (0 liczb całkowitych i przecinek nie są przechowywane), więc dla liczby 12.345 w komórce pamięci przeznaczonej do przechowywania mantysy zostanie zapisana liczba 12.345. unikalnie przywrócić oryginalny numer, pozostaje tylko zapisać go w kolejności, w tym przykładzie jest 2.

Kodowanie tekstu.

Zestaw znaków używany do pisania tekstu nazywa się alfabetem. Liczba znaków w alfabecie nazywana jest jego kardynalnością.

Do przedstawienia informacji tekstowych w komputerze najczęściej używany jest alfabet o pojemności 256 znaków. Jeden znak z takiego alfabetu zawiera 8 bitów informacji, ponieważ 2 8 \u003d 256. Ale 8 bitów tworzy jeden bajt, dlatego kod binarny każdego znaku zajmuje 1 bajt pamięci komputera.

Wszystkie znaki takiego alfabetu są ponumerowane od 0 do 255, a każdej liczbie odpowiada 8-bitowy kod binarny od 00000000 do 11111111. Kod ten jest liczbą porządkową znaku w systemie liczb binarnych.

W przypadku różnych typów komputerów i systemów operacyjnych używane są różne tabele kodowania, które różnią się kolejnością umieszczania znaków alfabetycznych w tabeli kodowania. Wspomniana już tabela kodowania ASCII to międzynarodowy standard na komputerach osobistych.

Zasada sekwencyjnego kodowania alfabetu polega na tym, że w tabeli kodów ASCII litery łacińskie (duże i małe) są ułożone w kolejności alfabetycznej. Układ liczb jest również uporządkowany rosnąco według wartości.

Standardowo w tej tabeli są tylko pierwsze 128 znaków, czyli znaki z liczbami od zera (kod binarny 00000000) do 127 (01111111). Obejmuje to litery alfabetu łacińskiego, cyfry, znaki interpunkcyjne, nawiasy i kilka innych symboli. Pozostałe 128 kodów, począwszy od 128 (kod binarny 10000000), a kończąc na 255 (11111111), służy do kodowania liter alfabetów narodowych, pseudografiki i symboli naukowych.

Kodowanie informacji graficznej.

Pamięć wideo zawiera binarne informacje o obrazie wyświetlanym na ekranie. Niemal wszystkie obrazy tworzone, przetwarzane lub oglądane za pomocą komputera można podzielić na dwie duże części – grafikę rastrową i wektorową.

Obrazy rastrowe to jednowarstwowa siatka punktów zwanych pikselami (piksel z angielskiego elementu obrazu). Kod piksela zawiera informacje o jego kolorze.

W przypadku obrazu czarno-białego (bez półtonów) piksel może przyjmować tylko dwie wartości: białą i czarną (świeci się - nie świeci), a do zakodowania wystarczy jeden bit pamięci: 1 - biały, 0 - czarny.

Piksel na kolorowym wyświetlaczu może mieć różne kolory, więc jeden bit na piksel nie wystarczy. Do zakodowania 4-kolorowego obrazu wymagane są dwa bity na piksel, ponieważ dwa bity mogą przyjmować 4 różne stany. Na przykład można zastosować tę opcję kodowania kolorami: 00 - czarny, 10 - zielony, 01 - czerwony, 11 - brązowy.

Na monitorach RGB całą różnorodność kolorów uzyskuje się przez połączenie podstawowych kolorów - czerwonego (czerwonego), zielonego (zielonego), niebieskiego (niebieskiego), z których można uzyskać 8 podstawowych kombinacji:

Oczywiście, jeśli masz możliwość kontrolowania intensywności (jasności) blasku podstawowych kolorów, to zwiększa się ilość różnych opcji ich kombinacji, generujących różne odcienie. Liczba różnych kolorów - DO i ilość bitów do ich zakodowania - n są połączone prostą formułą: 2 n = DO.

W przeciwieństwie do grafiki rastrowej warstwowy obraz wektorowy. Każdy element grafika wektorowa– linia, prostokąt, koło lub fragment tekstu – znajduje się na własnej warstwie, której piksele są ustawione niezależnie od innych warstw. Każdy element obrazu wektorowego jest obiektem opisanym za pomocą specjalnego języka (równania matematyczne linii, łuków, okręgów itp.) Obiekty złożone (linie łamane, różne kształty geometryczne) są reprezentowane jako zbiór elementarnych obiektów graficznych.

Obiekty grafiki wektorowej, w przeciwieństwie do grafiki rastrowej, mogą zmieniać swój rozmiar bez utraty jakości (ziarnistość wzrasta, gdy obraz rastrowy jest powiększony).

Kodowanie dźwięku.

Wiemy z fizyki, że brzmią są wibracje powietrza. Jeśli przekształcisz dźwięk na sygnał elektryczny (na przykład za pomocą mikrofonu), zobaczysz płynnie zmieniające się w czasie napięcie. Do przetwarzania komputerowego taki sygnał analogowy musi zostać w jakiś sposób przekształcony w ciąg liczb binarnych.

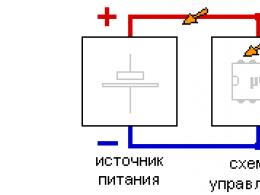

Odbywa się to na przykład w ten sposób - napięcie jest mierzone w regularnych odstępach czasu, a wynikowe wartości są zapisywane w pamięci komputera. Proces ten nazywa się próbkowaniem (lub digitalizacją), a urządzenie, które go wykonuje, nazywa się przetwornikiem analogowo-cyfrowym (ADC).

Aby odtworzyć dźwięk zakodowany w ten sposób, należy wykonać odwrotną konwersję (w tym celu używany jest przetwornik cyfrowo-analogowy). - DAC), a następnie wygładzić wynikowy sygnał kroku.

Im wyższa częstotliwość próbkowania i im więcej bitów jest przydzielonych dla każdej próbki, tym dokładniej będzie reprezentowany dźwięk, ale rozmiar pliku dźwiękowego również się zwiększy. Dlatego w zależności od charakteru dźwięku, wymagań co do jego jakości oraz ilości zajętej pamięci dobierane są pewne wartości kompromisowe.

Opisany sposób kodowania informacja dźwiękowa dość wszechstronny, pozwala na wyobrażenie sobie dowolnego dźwięku i przekształcenie go na różne sposoby. Ale są chwile, kiedy bardziej korzystne jest działanie w inny sposób.

Od dawna stosowany jest dość zwarty sposób przedstawiania muzyki - notacja muzyczna. Wskazuje specjalnymi symbolami, jaka jest wysokość dźwięku, na jakim instrumencie i jak grać. W rzeczywistości można go uznać za algorytm dla muzyka, napisany w specjalnym języku formalnym. W 1983 roku wiodący producenci komputerów i syntezatorów muzycznych opracowali standard, który zdefiniował taki system kodów. Nazywa się MIDI.

Oczywiście taki system kodowania pozwala na nagranie nie każdego dźwięku, nadaje się tylko do muzyki instrumentalnej. Ale ma też niezaprzeczalne zalety: niezwykle kompaktowe nagranie, naturalność dla muzyka (prawie każdy edytor MIDI pozwala na pracę z muzyką w postaci zwykłych nut), łatwość zmiany instrumentów, zmiany tempa i tonacji melodii.

Istnieją inne, czysto komputerowe, formaty nagrywania muzyki. Wśród nich jest format MP3, który pozwala na kodowanie muzyki o bardzo wysokiej jakości i kompresji, przy czym zamiast 18–20 kompozycji muzycznych na standardowej płycie kompaktowej (CDROM) umieszcza się około 200. Jeden utwór zajmuje około 3,5 Mb, co umożliwia użytkownikom Internetu łatwą wymianę utworów muzycznych.

Komputer jest uniwersalną maszyną informacyjną.

Jednym z głównych celów komputera jest przetwarzanie i przechowywanie informacji. Wraz z pojawieniem się komputerów stało się możliwe operowanie na niewyobrażalnych wcześniej ilościach informacji. Biblioteki zawierające literaturę naukową i beletrystyczną są przekształcane do postaci elektronicznej. Stare archiwa fotograficzne i filmowe otrzymują nowe życie w postaci cyfrowej.

Anna Czugajnowa

INFORMACJA (informatyka angielska), nauka o wydobywaniu informacji z komunikatów, tworzeniu zasobów informacyjnych, programowaniu zachowania maszyn i innych podmiotów związanych z budową i wykorzystaniem środowiska człowiek-maszyna do rozwiązywania problemów modelowania, projektowania, interakcji, uczenia się, itd. Bada właściwości informacji, metody ich wydobywania z przekazów i prezentowania w określonej formie; właściwości, metody i środki interakcji informacyjnej; właściwości zasobów informacji, metody i środki ich tworzenia, prezentacji, przechowywania, gromadzenia, wyszukiwania, przekazywania i ochrony; właściwości, metody i środki konstruowania i wykorzystywania programowalnych maszyn i środowiska człowiek-maszyna do rozwiązywania problemów.

Naukowa produkcja informatyki

Naukowa produkcja informatyki służy jako podstawa metodologiczna do konstruowania środowiska człowiek-maszyna do rozwiązywania problemów (ryc. 1) związanych z różnymi dziedzinami działalności.

Wyniki badań bytów (w nauce zwykle zwanych przedmiotami) są reprezentowane przez ich symboliczne i/lub modele fizyczne. Modele symboliczne to opisy nabytej wiedzy [zob. Modelowanie symboliczne(s-modeling)], a fizyczne to prototypy badanych obiektów, odzwierciedlające ich właściwości, zachowanie itp. Wynikiem naukowym jest model systemu wiedzy (lub składnik wcześniej zdefiniowanego i opublikowanego modelu), który opisuje zbiór obiektów, w tym badany obiekt, oraz relacje między nimi . Opis modelu przedstawiony jest w formie komunikatu przeznaczonego do rozpoznania i interpretacji przez środowisko naukowe. Wartość wyniku zależy od mocy predykcyjnej, odtwarzalności i stosowalności modelu, a także od właściwości komunikatu zawierającego jego opis.

Przykładami wyników, które odegrały wybitną rolę w metodologicznym wsparciu budowania środowiska człowiek-maszyna do rozwiązywania problemów, mogą być: model cyfrowej maszyny elektronicznej wynaleziony przez J. von Neumanna z instrukcjami programu i danymi przechowywanymi w pamięci współdzielonej [ znany jako model von Neumanna] i architektura von Neumanna] ; wymyślony przez twórcę sieci (por. Sieć ogólnoświatowa) T. Berners Lee Protokół HTTP (ang. Hypertext transfer protocol - hypertext transfer protocol), czyli protokół warstwy aplikacji definiujący zasady przesyłania wiadomości w systemach hipermedialnych (patrz Multimedia) oraz jednolity identyfikator zasobu URI (ang. Uniform Resource Identifier), który stał się standardem rejestrowania adresu zasobu zamieszczanego w Internecie. Trudno dziś (2017 r.) znaleźć dziedzinę działalności, w której naukowe wytwory informatyki nie są stosowane. Na jej podstawie stworzono pocztę elektroniczną, sieć, wyszukiwarki, telefonię IP, Internet rzeczy i inne usługi internetowe (patrz Internet); cyfrowe nagrywanie dźwięku, zdjęć i wideo; systemy komputerowego wspomagania projektowania (CAD); symulatory komputerowe i roboty (zob. Modelowanie komputerowe), systemy komunikacja cyfrowa, systemy nawigacyjne, drukarki 3D itp.

Podstawowe koncepcje

Postępującemu kształtowaniu się informatyki towarzyszy rozwój jej aparatu pojęciowego i dopracowanie przedmiotu badań. W 2006 roku w Instytucie Problemów Informatyki Akademia Rosyjska Sciences (IPI RAS) powstał nowy obszar badań - symboliczne modelowanie dowolnych obiektów w środowisku człowiek-maszyna (w skrócie- od symulacja symboliczna lub s-symulacja). Jeden z pierwszych projektów naukowych w tym obszarze poświęcony był metodologii budowy symbolicznego modelu informatycznego systemu wiedzy w środowisku człowiek-maszyna. . W teorii modelowania symbolicznego (s-modeling) stworzonej w 2009 roku zaproponowano kolejną wersję symbolicznego modelu rdzenia systemu pojęć informatycznych, która obejmuje następujące koncepcje.

Wiadomość(komunikat w języku angielskim) jest uważany za skończony uporządkowany zestaw symboli (wizualnych, dźwiękowych itp.; patrz Symbol w informatyce) lub jego kod (patrz Kod w informatyce), który spełnia protokół interakcji między źródłem a odbiorcą. Istnienie wiadomości zakłada istnienie źródła wiadomości, odbiorcy, nośnika, medium transmisyjnego, sposobu dostarczania i protokołu interakcji między źródłem a odbiorcą. W środowisku człowiek-maszyna do rozwiązywania problemów (s-environment) ludzie za pomocą programowalnych maszyn (s-machines) tworzą komunikaty, prezentując je w językach zapytań, programowaniu itp.; wykonywać różne konwersje (np. z analogowego na cyfrowy i odwrotnie; z nieskompresowanego do skompresowanego i odwrotnie; z jednej formy reprezentacji dokumentu do innej); rozpoznawać, wykorzystywać wiadomości do konstruowania nowych wiadomości (programów, dokumentów itp.); interpretować na modelach systemów pojęciowych (które są przechowywane w pamięci tłumacza również w postaci komunikatów); wymieniać wiadomości za pomocą systemów reguł zaimplementowanych programowo i sprzętowo (protokoły sieciowe, patrz poniżej). Śieć komputerowa); zapisuj i gromadź wiadomości (poprzez tworzenie elektronicznych bibliotek, encyklopedii i innych zasobów informacyjnych), rozwiązuj problemy wyszukiwania i ochrony wiadomości.

Tłumacz wiadomości jest badany jako konstruktor komunikatu wyjściowego według danych wejściowych zgodnie z przyjętym systemem reguł interpretacji. Warunkiem koniecznym do skonstruowania interpretera komunikatów jest istnienie modeli języków wejściowych i wyjściowych oraz modeli systemów pojęciowych, na których należy interpretować komunikaty napisane w językach wejściowych i wyjściowych.

Dane(dane angielskie) - komunikat niezbędny do rozwiązania określonego problemu lub zestawu problemów, przedstawiony w formie przeznaczonej do rozpoznania, przekształcenia i interpretacji przez osobę rozwiązującą (program lub osobę). Osoba postrzega dane (tekst, obrazy itp.) w formie symbolicznej, podczas gdy program komputerowy lub urządzenie komputerowe (smartfon, aparat cyfrowy itp.) postrzega je w kodzie.

Informacja(informacja angielska) jest badana w wyniku interpretacji przekazu na modelu systemu pojęć [zob. Modelowanie symboliczne(s-symulacja)]. Aby wydobyć informacje z wiadomości, konieczne jest przedstawienie otrzymanej wiadomości w formie zaprojektowanej do rozpoznania i interpretacji przez odbiorcę wiadomości; modele systemu pojęciowego przechowywane w pamięci tłumacza, wśród których jest ten niezbędny do interpretacji odebranego komunikatu; mechanizmy wyszukiwania potrzebnego modelu, interpretacji przekazu, prezentowania wyniku interpretacji w formie przeznaczonej dla odbiorcy (rys. 2).

Na przykład wynikiem interpretacji komunikatu ma, przedstawionego w języku a, otrzymanego przez tłumacza (człowieka lub robota) w postaci komunikatu mb w języku b, jest informacja wydobyta z komunikatu ma.

Programowalne zadanie(s-problem) jest uważany za zbiór (Formul , Rulsys , Alg , Prog ), gdzie Formul jest opisem problemu; Rulsys - zestaw systemów obowiązkowych i ukierunkowanych reguł rozwiązywania problemu, zgodny z Formułą; Alg to połączenie zestawów algorytmów, z których każdy odpowiada jednemu elementowi z Rulsys ; Prog to połączenie zestawów programów, z których każdy jest przypisany do jednego z elementów Alg . Każdemu elementowi z Rulsys , Alg i Prog należy nadać opis zastosowania. Opisy wykorzystania elementów Rulsys zawierają określenie rodzaju rozwiązania problemu (autonomiczny s-machine, współpraca sieciowa s-maszyny, współpraca człowiek-s-maszyna itp.), wymagania bezpieczeństwa informacji itp. Opisy wykorzystania elementy z Alg obejmują dane o akceptowalnych trybach pracy rozwiązywania problemów (automatyczny lokalny, automatyczny rozproszony, interaktywny lokalny itp.), wymagania dla uzyskanego wyniku itp. Opisy zastosowań programów zawierają dane dotyczące języków implementacji, systemów operacyjnych itp.

Algorytm– sformalizowany opis skończonego zestawu kroków do rozwiązania problemu, odpowiadający jednemu z elementów Rulsys i pozwalający na zgodność jeden do jednego z danym zbiorem danych wejściowych z wynikowym zbiorem danych wyjściowych.

Program– algorytm zaimplementowany w języku programowania wysokiego poziomu, języku zorientowanym maszynowo i/lub w systemie instrukcji maszynowych. Przedstawione w formie komunikatu definiującego zachowanie rozwiązania problemu s-machine o zadanych właściwościach. Występuje w symbolicznych, kodowych i sygnałowych wcieleniach, połączonych relacjami translacji (patrz Kompilator w informatyce).

Symbol(symbol angielski) - substytut przedmiotu naturalnego lub wymyślonego, oznaczający ten przedmiot i będący elementem pewnego systemu konstruowania komunikatów symbolicznych (tekstów, notacji muzycznych itp.), przeznaczonych do odbioru przez człowieka lub robota. Na przykład alfabet rosyjski to system symboli tekstowych; litera A w tym systemie jest symbolem, który zastępuje odpowiedni dźwięk z systemu symboli dźwiękowych mowy języka rosyjskiego; Litera A odpowiada dotykowemu symbolowi tekstury (odbieranemu przez dotyk palcami) w systemie wiadomości tekstowych dla niewidomych, znanym jako Braille (patrz ryc. Brajl). Zestaw symboli wizualnych, dźwiękowych i innych wybranych do budowania wiadomości określonego typu jest uważany za zestaw elementarnych konstruktywnych obiektów, z których każdy jest wyposażony w zestaw atrybutów i zestaw dozwolonych operacji. O tworzeniu struktur z elementów tego zbioru decyduje system reguł konstruowania modeli symbolicznych [więcej szczegółów w artykule Symbol w informatyce (s-symbol)].

Kod(kod angielski) - substytut symbolu lub komunikatu symbolicznego używany do ich reprezentowania w komputerach, smartfonach i innych programowalnych maszynach i przeznaczony do budowania, zapisywania, przesyłania i interpretacji komunikatów symbolicznych [więcej szczegółów w artykule Kod w informatyce ( s-kod)].

Sygnał(ang. signal) - oddziaływanie optyczne, dźwiękowe lub inne odbierane przez zmysły ludzkie lub czujniki maszynowe lub przedstawienie kodu w postaci częstotliwości promieniowanie elektromagnetyczne, kompozycje wartości napięcia elektrycznego lub inne, zaprojektowane tak, aby były odbierane przez sprzęt maszyny (na przykład centralny procesor komputera, mikroprocesor nawigator samochodowy). Symbole, kody i sygnały są połączone relacjami transformacji. Każdemu symbolowi i konstrukcji symbolicznej, przeznaczonej do percepcji przez człowieka lub robota, można przypisać korespondencję jeden do jednego z kodami przeznaczonymi do manipulowania nimi za pomocą oprogramowania komputerowego i urządzeń komputerowych.

Koncepcyjny model systemu. Model S Wady systemu pojęć jest uważany za parę (ConsSet , ConsRel ), gdzie ConsSet jest zbiorem pojęć; ConsRel to rodzina relacji zdefiniowanych w ConsSet . Definicja systemu pojęć – opis jego modelu wraz ze wskazaniem zakresu. Opis przedstawiany jest w formie komunikatu przeznaczonego do interpretacji przez odbiorcę, prezentacji, przechowywania, dystrybucji, gromadzenia i przeszukiwania w środowisku człowiek-maszyna aktywności intelektualnej. System pojęć uznanych za określone nie powinien zawierać pojęć, które nie mają definicji (a jednocześnie nie są związane z pojęciami-aksjomatami). Określenie zakresu stosowalności modelu – opis rodzajów korespondentów (do których adresowana jest definicja), cel w procesie osiągania, którego definicja ma sens (klasy zadań w badaniu których definicja może być przydatna), etap, na którym wskazane jest posługiwanie się definicją (koncepcja, metodologia rozwiązania itp.) d.).

Model systemu wiedzy. Pojęcie „wiedzieć” w s-modelowaniu [zob. Modelowanie symboliczne(s-symulacja)] definiuje się jako stan odbiorcy komunikatu, gdy komunikat wyjściowy uzyskany w wyniku interpretacji komunikatu wejściowego jest rozpoznawany jako już znany i nie wymaga zmian w modelach systemów pojęciowych przechowywanych w pamięci odbiorca wiadomości. Pojęcie „wiedzy” definiuje się jako złożoną zdolność do wydobywania informacji z wiadomości zawierających warunki zadań określonej klasy (mogą to być zadania rozpoznawania wzorców, tłumaczenia z jednego języka na inny lub inne klasy zadań). Model S systemu wiedzy jest uważany za triadę (Cons , Lang , Interp ), gdzie Cons jest s-modelem systemu pojęć; Lang jest s-modelem zbioru języków komunikatów interpretowanych na Cons ; Interp to s-model zbioru tłumaczy na Wady wiadomości skomponowanych w językach z Lang.

Interpretacja przekazu na temat modelu Cons obejmuje:

1) budowanie komunikatu wyjściowego (wyodrębnianie informacji) zgodnie z zadanym komunikatem wejściowym (komunikaty prezentowane są w językach z ustawionego Lang );

2) analiza komunikatu wyjściowego (czy wymagane są zmiany w modelu Cons);

3) w razie potrzeby zmień model Wady; jeśli nie, zakończ.

Na przykład mózgiem nowoczesnego systemu projektowania wspomaganego komputerowo (CAD) jest system wiedzy. Wydajność projektowania zależy od tego, jak dobrze jest zbudowane.

Programowalna maszyna(s-machine) to struktura oprogramowania i sprzętu do rozwiązywania problemów. Superkomputery, komputery mainframe, komputery osobiste, laptopy, smartfony, nawigatory, aparaty cyfrowe i kamery wideo to s-samochody. Klawiatury, myszy, trackballe, touchpady i inne urządzenia wejściowe to elementy s-machine, które konwertują znaki na kody akceptowane przez sterowniki (patrz Kierowca w informatyce) odpowiednich urządzeń. Monitory komputerów osobistych, wyświetlacze laptopów, nawigatory itp. konwertują kody generowane przez kontrolery wideo na symboliczne kompozycje przeznaczone dla kanału wzrokowego człowieka.

(s-environment) - związek sieci komputerowych i indywidualnych programowalnych maszyn służących do rozwiązywania różnych problemów. Sposoby informatyzacji różnych rodzajów działalności. Środowisko S musi zapewniać reprezentację kodów cyfrowych modeli symbolicznych i manipulację takimi kodami za pomocą s-machines. W sercu nowoczesnych technologii komunikacji cyfrowej, projektowania wspomaganego komputerowo itp. stoi idea godna uwagi ze względu na konsekwencje jej wdrożenia - sprowadzić całą różnorodność symboliczną do kodów cyfrowych [a każdy z nich do jednego kodu (nadal mają kod binarny)] i instruują pracę z kodami programowalnym maszynom, połączonym w środowisko człowiek-maszyna do rozwiązywania problemów.

Interakcja informacyjna w s-medium(Rys. 3) jest rozpatrywany jako zestaw interfejsów, takich jak „człowiek – człowiek”, „człowiek – program”, „człowiek – sprzęt programowalnej maszyny”, „program – program”, „program – sprzęt” (patrz Interfejs Port w informatyce). Osoba odbiera wejściowe sygnały analogowe (światło, dźwięk itp.) Za pomocą wizualnych, słuchowych i innych urządzeń wejściowych biointeligencji (system biologiczny zapewniający funkcjonowanie intelektu). Zamienia interesujące go sygnały na symboliczne konstrukcje wizualne, dźwiękowe i inne wykorzystywane w procesach myślenia. Sygnały wyjściowe biointeligencji realizowane są za pomocą gestów (np. przy wchodzeniu z klawiatury i myszy), mowy itp. . Dane wejściowe i wyjściowe programów to dane wejściowe i kody wyników (patrz rys. Kod w informatyce), a wejścia i wyjścia sprzętu są sygnałami. Wejściowe sygnały analogowe są konwertowane na sygnały cyfrowe za pomocą przetworniki analogowo-cyfrowe(ADC), a wyjście cyfrowe na analogowe za pomocą przetworniki cyfrowo-analogowe(DAC).

We współczesnym (2017) środowisku s, naturalne sposoby percepcji, przetwarzania i przechowywania sygnałów człowieka są uzupełniane przez wymyślone: cyfrowe kamery fotograficzne i wideo, smartfony itp. Znaną częścią technologii interakcji informacji jest szybko rozwijająca się Usługi internetowe. Używane do interakcji z ludźmi E-mail(angielski e-mail), różne rodzaje połączeń internetowych [ Telefonia internetowa(telefonia IP); na przykład zaimplementowane w usłudze internetowej Skype; posłańcy (angielski komunikator - połączony); na przykład usługa internetowa Telegram), sieci społecznościowe (angielskie sieci społecznościowe) itp. W celu interakcji rzeczy używanych przez ludzi (systemy oświetleniowe, utrzymanie temperatury itp.) między sobą i ze środowiskiem zewnętrznym technologie informacyjne „ Internet rzeczy” (patrz. Internet ).

Podstawowe klasy zadań

Na podstawie badania właściwości i wzorów modelowanie symboliczne(s-symulacja) definiuje się następujące klasy podstawowych problemów informatycznych.

Reprezentowanie arbitralnych modeli obiektowych, zaprojektowany z myślą o ludzkiej percepcji i programowalnych maszynach, wiąże się z wynalezieniem języków komunikatów spełniających określone wymagania. Ta klasa bada systemy symboli i kodów używane odpowiednio w językach zorientowanych na człowieka i maszynę. Pierwsza obejmuje języki specyfikacji, programowania, zapytań, druga – systemy instrukcji maszynowych. Ta klasa obejmuje również zadania prezentacji danych. Zawiera zadania reprezentowania modeli systemów pojęciowych, na których interpretowane są komunikaty. Na najwyższym poziomie hierarchii zadań tej klasy znajduje się reprezentacja modeli systemów wiedzy.

Konwersja typów i form reprezentacji modeli symbolicznych pozwala na ustalenie korespondencji między modelami. Zadania konwersji typów (na przykład mowy na tekst i odwrotnie) oraz formularzy (na przykład analogowych na cyfrowe i odwrotnie; nieskompresowane na skompresowane i odwrotnie; *.doc na *.pdf) są niezbędnym uzupełnieniem zadania reprezentowania modeli.

Rozpoznawanie wiadomości implikuje konieczność przedstawienia go w formacie znanym odbiorcy. Gdy ten warunek jest spełniony, aby rozpoznać komunikat, rozwiązywane są zadania dopasowania do modeli modeli lub dopasowania właściwości rozpoznanego modelu do właściwości modeli modeli. Na przykład w zadaniu biometrycznej identyfikacji osoby jej dane biometryczne (komunikat wejściowy) są porównywane z próbką biometryczną z bazy danych systemu biometrycznego.

Budowa modelu systemy pojęć, systemy wiedzy, interpretery wiadomości na modelach systemów pojęć; modele zadań, technologie programowania, interakcja w środowisku s; modele architektury maszyn-s, sieci komputerowych, architektury zorientowane na usługi; modele wiadomości i sposoby ich budowy, dokumenty i obieg. Na najwyższym poziomie hierarchii tej klasy znajdują się zadania konstruowania modeli s-środowiska i symbolicznych technologii modelowania.

Interpretacja wiadomości(wydobywanie informacji) zakłada istnienie odebranego komunikatu, modelu systemu pojęć, na podstawie którego należy go interpretować, oraz mechanizmu interpretacji. Rozwiązywanie problemów w środowisku człowiek-maszyna polega na interpretacji danych wyjściowych (komunikatu wejściowego) na przedstawionym w algorytmie modelu układu pojęć. Wynikiem rozwiązania jest komunikat wyjściowy (informacje wyodrębnione z komunikatu wejściowego). Jeśli interpreter jest programem wykonywalnym, wówczas dane początkowe, program i wynik rozwiązania problemu są reprezentowane przez odpowiednie kody (patrz Kod w informatyce). Dla mikroprocesora programowalnej maszyny interpretowane komunikaty i wyniki interpretacji są reprezentowane przez sygnały odpowiadające rozkazom maszyny i kodom danych. Np. podczas fotografowania aparatem cyfrowym komunikat (w postaci sygnału świetlnego) oddziałuje na matrycę światłoczułą, jest przez nią rozpoznawany, a następnie konwertowany na kod obrazu cyfrowego, który jest interpretowany przez program poprawiający obraz jakość. Otrzymany wynik jest konwertowany i zapisywany (na wbudowanej pamięci aparatu lub na karcie pamięci) jako plik graficzny.

Wymiana wiadomości: zadania konstruowania interfejsów typu "człowiek - człowiek", "człowiek - program", "człowiek - sprzęt programowalnej maszyny", "program - program", "program - sprzęt" (patrz Interfejs w informatyce), " sprzęt - sprzęt” (patrz Port w informatyce); zadania przesyłania wiadomości w środowisku człowiek-maszyna do rozwiązywania problemów (z typowaniem nadawców i odbiorców; sposoby wysyłania, przesyłania i odbierania wiadomości; środowiska przesyłania wiadomości). Wynaleziono systemy reguł wymiany wiadomości (protokoły sieciowe); architektury sieciowe; systemy zarządzania dokumentami. Na przykład wiadomości są wymieniane między procesami system operacyjny(OS), programy s-machine w sieci komputerowej, użytkownicy poczty e-mail itp.

Zapisywanie, gromadzenie i wyszukiwanie wiadomości: urządzenia pamięciowe i magazynujące, ich mechanizmy kontrolne są badane i typizowane; formy konserwacji i akumulacji; media, metody konserwacji, gromadzenia i wyszukiwania; bazy danych i biblioteki oprogramowania. Badane są modele przedmiotu przeszukiwania (według modelu, cech, opisu właściwości) oraz metody przeszukiwania.

Ochrona informacji: badane są problemy zapobiegania i wykrywania podatności, kontroli dostępu, ochrony przed włamaniami, złośliwym oprogramowaniem, przechwytywaniem wiadomości i nieautoryzowanym użyciem.

Obszary badawcze

Najważniejsze idee naukowe wpływające na rozwój informatyki ucieleśnione są w metodologicznym wsparciu budowy narzędzi wspierających procesy poznania, interakcji informacyjnej i automatycznego rozwiązywania różnych problemów. Na obecnym etapie (2017) rozwoju informatyki istotne są następujące powiązane ze sobą kompleksy obszarów badawczych.

Automatyzacja obliczeń(obliczenia za pomocą programowalnych maszyn): badane są modele, architektury i systemy dowodzenia programowalnych maszyn; algorytmizacja zadań programowalnych [algorytmy i struktury danych, algorytmy rozproszone (algorytmy rozproszone), algorytmy randomizowane (algorytmy losowe) itp.]; przetwarzanie rozproszone (Distributed Computing), przetwarzanie w chmurze (Cloud Computing); złożoność i zasobochłonność obliczeń.

Programowanie: badane są systemy symboli tekstowych i kodów; języki programowania i specyfikacje zadań; tłumacze; biblioteki programów; Programowanie systemu; System operacyjny; systemy programowania instrumentalnego; systemy zarządzania bazą danych; technologie programowania; usługi online do rozwiązywania problemów itp.

Środowisko człowiek-maszyna do rozwiązywania problemów(s-środowisko): badane są modele, metody i narzędzia budowy s-środowiska, sieci komputerowe, cyfrowe sieci komunikacyjne, Internet.

Percepcja i prezentacja komunikatów, interakcja w środowisku s: badane są modele, metody i środki percepcji i prezentacji komunikatów wizualnych, dźwiękowych, dotykowych i innych; komputerowe czujniki wzroku, słuchu i inne sztuczne czujniki; tworzenie komunikatów dźwiękowych, wizualnych, dotykowych i innych (w tym łączonych) przeznaczonych dla osoby i robota partnerskiego; rozpoznawanie komunikatów dźwiękowych, wizualnych i innych (mowy, gestów itp.); przetwarzanie obrazu, grafika komputerowa, wizualizacja itp.; wymiana komunikatów (modele komunikatów, metody i środki ich odbioru i transmisji); interfejsy użytkownika, programy, sprzęt, programy ze sprzętem; usługi interakcji online (komunikatory, sieci społecznościowe itp.).

Zasoby informacyjne i systemy rozwiązywania problemów w środowisku s: badane są modele, metody i środki konstruowania, przedstawiania, zachowywania, gromadzenia, wyszukiwania, przekazywania i ochrony zasobów informacyjnych; elektroniczne zarządzanie dokumentami; biblioteki elektroniczne i inne systemy informacyjne; sieć (patrz Sieć ogólnoświatowa).

Bezpieczeństwo informacji i kryptografia: badane są metody zapobiegania i wykrywania podatności; kontrola dostępu; ochrona systemów informatycznych przed włamaniami, złośliwym oprogramowaniem, przechwyceniem wiadomości; nieuprawnione korzystanie z zasobów informacyjnych, oprogramowania i sprzętu.

Sztuczna inteligencja: badane są modele, metody i narzędzia do budowy inteligentnych robotów wykorzystywanych jako ludzki partner (do rozwiązywania problemów bezpieczeństwa, sterowania sytuacyjnego itp.); eksperckie metody podejmowania decyzji.

Modelowanie symboliczne: badane są systemy symboli wizualnych, dźwiękowych, dotykowych i innych, uważanych za konstruktywne obiekty do budowania modeli dowolnych jednostek zaprojektowanych dla osoby (systemy pojęć i systemów wiedzy, obiekty środowiskowe i obiekty wymyślone przez ludzi); systemy kodów, umieszczone w korespondencji z systemami symboli, które są przeznaczone do budowy ekwiwalentów kodu modeli symbolicznych, przeznaczone do manipulacji za pomocą programów; języki opisu modeli symbolicznych; typowanie modeli symbolicznych i ich kodowych odpowiedników; metody konstruowania symbolicznych modeli systemów pojęć i systemów wiedzy (w tym systemów wiedzy o zadaniach programowalnych) [więcej szczegółów w artykule Modelowanie symboliczne(s-symulacja)].

Powstawanie informatyki

Modelowanie symboliczne badanych obiektów od dawna służy jako główne narzędzie prezentacji zdobytej wiedzy. Wynalezienie symboli (gestowych, graficznych itp.) i zbudowanych z nich symboli przekazu symbolicznego, reprezentacja i akumulacja takich modeli w środowisku zewnętrznym stały się kluczowymi środkami kształtowania i rozwoju zdolności intelektualnych. O dominującej roli wzorców symbolicznych w aktywności intelektualnej decyduje nie tylko ich zwartość i wyrazistość, ale także brak ograniczeń co do rodzajów nośników służących do ich przechowywania. Nośnikiem może być pamięć ludzka, kartka papieru, matryca aparatu cyfrowego, pamięć cyfrowego dyktafonu lub coś innego. Koszty budowy, kopiowania, przenoszenia, zapisywania i gromadzenia modeli symbolicznych są nieporównywalnie mniejsze niż podobne koszty związane z modelami niesymbolicznymi (np. modele statków, budynków itp.). Bez symbolicznych narzędzi modelowania trudno wyobrazić sobie rozwój nauki, inżynierii i innych działań.

We wczesnych stadiach rozwoju modelowania różnorodność modelowanych obiektów ograniczała się do tego, co powszechnie nazywa się obiektami środowiskowymi, a modele tych obiektów były fizyczne. Rozwój dźwięku, gestu i innych środków symbolicznego modelowania znaczeń, spowodowany koniecznością zgłaszania niebezpieczeństwa, umieszczania przedmiotów myśliwskich i innych przedmiotów obserwacji, przyczynił się do udoskonalenia mechanizmów poznania, wzajemnego zrozumienia i uczenia się. Zaczęły tworzyć się języki wiadomości, w tym symbole dźwięków i gestów. Chęć modelowania zachowania (w tym własnego) stawia nowe wyzwania. Można przypuszczać, że początkowo pragnienie to wiązało się z uczeniem racjonalnego zachowania na polowaniu, w życiu codziennym, podczas klęsk żywiołowych. Na pewnym etapie pomyśleli o stworzeniu takich narzędzi do modelowania, które pozwoliłyby na budowanie modeli pozwalających na ich przechowywanie, kopiowanie i przenoszenie.

Chęć zwiększenia skuteczności wyjaśnień towarzyszących pokazowi doprowadziła do udoskonalenia aparatu pojęciowego i środków jego wcielania mowy. Rozwój modeli symbolicznych w postaci schematów graficznych oraz doskonalenie mowy doprowadziły do powstania graficznego modelu mowy. Pisanie zostało stworzone. Stał się nie tylko ważnym etapem w rozwoju modelowania symbolicznego, ale także potężne narzędzie w rozwoju aktywności intelektualnej. Teraz opisy obiektów modelowania i relacji między nimi można przedstawić za pomocą kompozycji tekstów, diagramów i rysunków. Stworzono zestaw narzędzi do wyświetlania obserwacji, rozumowań i planów w formie symbolicznych modeli, które można było przechowywać i przesyłać. Aktualne stały się zadania wynalezienia mediów, narzędzi do pisania i tworzenia obrazów, barwników itp. Były to pierwsze zadania na drodze do zbudowania symbolicznego środowiska modelowania.

Ważny etap modelowania graficznego związany jest z modelami obrazów schematycznych (przodkami rysunków) - podstawą projektowania. Prezentacja projektowanego obiekt trójwymiarowy w trzech dwuwymiarowych rzutach, które pokazują wymiary i nazwy części, odegrały decydującą rolę w rozwoju inżynierii. W drodze od odręcznych tekstów, rysunków i diagramów do typografii i modeli graficznych w projektowaniu, od nagrań dźwiękowych, fotografii i radia do kina i telewizji, od komputerów i sieci lokalnych do sieci globalnej, wirtualnych laboratoriów i edukacji na odległość, rola symbolu modele, które człowiek tworzy za pomocą maszyn.

Produktywność osób rozwiązujących problemy jest kluczowym problemem produktywności aktywności intelektualnej, która jest stale w centrum uwagi wynalazców. Potrzeba ilościowych ocen obiektów materialnych od dawna była bodźcem do wynalezienia systemów dźwiękowych, gestów, a następnie symboli graficznych. Przez jakiś czas radzili sobie z zasadą: każda wartość ma swój własny symbol. Liczenie za pomocą kamyków, patyków i innych przedmiotów (liczenie obiektywne) poprzedziło wynalezienie liczenia symbolicznego (opartego na reprezentacja graficzna wielkie ilości). Wraz ze wzrostem liczby przedmiotów, które należało wykorzystać, zadanie symbolicznego przedstawienia wielkości stawało się coraz pilniejsze. Powstanie pojęcia „liczby” i idea zapisywania symboli podczas modelowania liczb doprowadziła do wynalezienia systemów liczbowych. Na szczególną uwagę zasługuje idea systemów liczb pozycyjnych, z których jeden (binarny) powstał w XX wieku. miał odegrać kluczową rolę w wynalezieniu cyfrowych programowalnych maszyn i cyfrowego kodowania modeli postaci. Zmiana znaczenia symbolu wraz ze zmianą jego pozycji w sekwencji symboli to bardzo produktywny pomysł, który zapewnił postęp w wynalezieniu urządzeń obliczeniowych (od liczydła do komputera).

Narzędzia zwiększające produktywność osób rozwiązujących problemy. W latach 1622–33 angielski naukowiec William Otred zaproponował wariant suwak suwakowy, który stał się prototypem suwaków logicznych, z których inżynierowie i badacze na całym świecie korzystali od ponad 300 lat (zanim pojawiły się komputery osobiste). W 1642 r. B. Pascal, próbując pomóc ojcu w obliczeniach przy pobieraniu podatków, tworzy pięciocyfrowe urządzenie sumujące („Pascaline” ), zbudowany na bazie kół zębatych. W kolejnych latach stworzył urządzenia sześcio- i ośmiocyfrowe, które miały za zadanie dodawać i odejmować liczby dziesiętne. W 1672 r. niemiecki naukowiec G.W. Leibniz tworzy cyfrowy kalkulator mechaniczny do operacji arytmetycznych na dwunastocyfrowych liczbach dziesiętnych. Był to pierwszy kalkulator, który zrobił wszystko działania arytmetyczne. Mechanizm, zwany kołem Leibniza, do lat 70. XX wieku. reprodukowane w różnych kalkulatorach podręcznych. W 1821 r. rozpoczęto przemysłową produkcję maszyn sumujących. W latach 1836-48 C. Babbage zrealizował projekt mechanicznego komputera dziesiętnego (zwanego przez niego silnikiem analitycznym), który można uznać za mechaniczny prototyp przyszłych komputerów. Program obliczeniowy, dane i wynik zostały zapisane na kartach perforowanych. Automatyczne wykonanie dostarczone programy urządzenie sterujące. Samochód nie został zbudowany. W 1934 - 38 K. Zuse stworzył mechaniczny komputer binarny (długość słowa– 22 cyfry binarne; pamięć– 64 słowa; operacje zmiennoprzecinkowe). Początkowo program i dane były wprowadzane ręcznie. Około rok później (po rozpoczęciu projektowania) wykonano urządzenie do wprowadzania programu i danych z folii perforowanej, a mechaniczną jednostkę arytmetyczną (AU) zastąpiono AU zbudowaną na przekaźnikach telefonicznych. W 1941 roku Zuse, przy udziale austriackiego inżyniera H. Schreiera, stworzył pierwszy na świecie działający całkowicie przekaźnikowy komputer binarny ze sterowaniem programowym (Z3). W 1942 roku Zuse stworzył również pierwszy na świecie komputer sterujący (S2), który służył do sterowania samolotami pociskowymi. Ze względu na tajność prac wykonywanych przez Zuse ich wyniki stały się znane dopiero po zakończeniu II wojny światowej. Pierwszy na świecie język programowania wysokiego poziomu Plankalkül (niemiecki Plankalkül - plan rachunku różniczkowego) został stworzony przez Zuse w latach 1943-45, opublikowany w 1948 roku. Pierwsze cyfrowe komputery elektroniczne, począwszy od amerykańskiego komputera ENIAC [(ENIAC - Electronic Numerical Integrator and Computer - elektroniczny integrator numeryczny i kalkulator); początek rozwoju - 1943, zaprezentowany publicznie w 1946], powstały jako środek automatyzacji obliczeń matematycznych.

Tworzenie nauki o obliczeniach za pomocą programowalnych maszyn. Wszystkie R. XX wiek rozpoczęła się produkcja komputerów cyfrowych, które w USA i Wielkiej Brytanii nazywano komputerami (komputerami), aw ZSRR - komputerami elektronicznymi (komputerami). Od lat 50. XX wieku w Wielkiej Brytanii, a od lat 60. w USA zaczęła się rozwijać nauka informatyczna za pomocą programowalnych maszyn, zwana informatyką (computer science). W 1953 Uniwersytet Cambridge powstał program na specjalności Informatyka; w USA podobny program został wprowadzony w 1962 roku na Purdue University.

W Niemczech informatykę nazywano Informatik (informatyka). W ZSRR dziedzinę badań i inżynierii poświęconą budowie i zastosowaniu programowalnych maszyn nazywano „technologią komputerową”. W grudniu 1948 r. I. S. Bruk i B. I. Rameev otrzymali pierwszy w ZSRR certyfikat praw autorskich na wynalezienie automatycznej maszyny cyfrowej. W latach pięćdziesiątych stworzył pierwszą generację komputerów domowych ( podstawa elementu- lampy próżniowe): 1950 - MESM (pierwszy sowiecki komputer elektroniczny, opracowany pod kierownictwem S.A. Lebiediew ); 1952 - M-1, BESM (do 1953 najszybszy komputer w Europie); 1953 - „Strzałka” (pierwszy komputer masowo produkowany w ZSRR); 1955 - Ural-1 z rodziny Ural komputerów cyfrowych ogólnego przeznaczenia (główny projektant B.I. Rameev).

Doskonalenie metod i środków automatyzacji. Wraz z rosnącą dostępnością komputerów dla użytkowników z różnych dziedzin działalności, która rozpoczęła się w latach 70., zmniejsza się udział problemów matematycznych rozwiązywanych za pomocą komputerów (pierwotnie stworzonych jako środek do automatyzacji obliczeń matematycznych), a wzrost udział problemów niematematycznych (komunikacja, wyszukiwanie itp.). Kiedy w drugiej połowie lat sześćdziesiątych. rozpoczęto produkcję terminali komputerowych z ekranami, rozpoczęto opracowywanie programów do edycji ekranów do wprowadzania, zapisywania i poprawiania tekstu z wyświetlaniem go na pełnym ekranie [jednym z pierwszych edytorów ekranowych był O26, stworzony w 1967 roku dla operatorów konsol serii CDC 6000 komputery; w 1970 roku powstał vi, standardowy edytor ekranów dla systemów operacyjnych Unix i Linux]. Zastosowanie edytorów ekranowych nie tylko zwiększyło produktywność programistów, ale także stworzyło warunki do istotnych zmian w narzędziach do zautomatyzowanej budowy modeli symbolicznych dowolnych obiektów. Na przykład używanie edytorów ekranowych do generowania tekstów do różnych celów(artykuły i książki naukowe, podręczniki itp.) już w latach 70. XX wieku. pozwoliło znacznie zwiększyć produktywność tworzenia zasobów informacji tekstowych. W czerwcu 1975 roku amerykański badacz Alan Kay [twórca obiektowego języka programowania Smalltalk i jeden z autorów idei komputera osobistego] w artykule „Personal Computing” (« Komputery osobiste» ) napisał: „Wyobraź sobie siebie jako właściciela autonomicznej maszyny wiedzy w przenośny futerał, który jest wielkością i kształtem zwykłego notatnika. Jak byś go używał, gdyby jego czujniki były lepsze od wzroku i słuchu, a jego pamięć pozwalała przechowywać i w razie potrzeby wydobyć tysiące stron materiałów źródłowych, wierszy, listów, przepisów, a także rysunków, animacji, muzyki , grafiki, dynamiczne modele i coś jeszcze, co chciałbyś stworzyć, zapamiętać i zmienić? . Stwierdzenie to odzwierciedlało zwrot, jaki dokonał się do tego czasu w podejściu do budowy i zastosowania maszyn programowalnych: od narzędzi automatyzacji, głównie obliczeń matematycznych, po narzędzia do rozwiązywania problemów z różnych dziedzin działalności. W 1984 Kurzweil Music Systems (KMS), stworzony przez amerykańskiego wynalazcę Raymonda Kurzweila, wyprodukował pierwszy na świecie cyfrowy syntezator muzyczny, Kurzweil 250. Był to pierwszy na świecie dedykowany komputer, który konwertował znaki gestów wprowadzane z klawiatury na dźwięki muzyczne.

Doskonalenie metod i środków interakcji informacyjnej. W 1962 roku amerykańscy badacze J. Licklider i W. Clark opublikowali raport na temat interakcji człowiek-maszyna online. Raport zawierał uzasadnienie celowości budowy globalnej sieci jako platformy infrastrukturalnej zapewniającej dostęp do zasobów informacyjnych znajdujących się na komputerach podłączonych do tej sieci. Teoretyczne uzasadnienie komutacji pakietów w transmisji wiadomości w sieciach komputerowych zostało podane w artykule opublikowanym w 1961 roku przez amerykańskiego naukowca L. Kleinrocka.W 1971 r. R. Tomlinson (USA) wynalazł e-mail, w 1972 r. usługa ta została wdrożona. Kluczowym wydarzeniem w historii powstania Internetu było wynalezienie w 1973 roku przez amerykańskich inżynierów V. Cerfa i R. Kahna protokołu kontroli transmisji - TCP. W 1976 roku zademonstrowali transmisję pakietu sieciowego przez protokół TCP. W 1983 roku rodzina protokołów TCP/IP została ustandaryzowana. W 1984 r. utworzono system nazw domen (DNS) (zob. Domena w informatyce). W 1988 r. opracowano protokół czatu [Internet Real Time Text Messaging Service (IRC - Internet Relay Chat)]. W 1989 r. wdrożono projekt sieciowy (zob. Sieć ogólnoświatowa) opracowany przez T. Berners Lee. 6.6.2012 - znaczący dzień w historii Internetu: najwięksi dostawcy Internetu, producenci sprzętu dla sieć komputerowa a firmy internetowe zaczęły używać protokołu IPv6 (wraz z protokołem IPv4), praktycznie rozwiązując problem niedoboru adresów IP (patrz Internet). Wysokiemu tempu rozwoju Internetu sprzyja fakt, że od początku jego istnienia profesjonaliści zajmujący się naukowymi i technicznymi zadaniami budowy Internetu bez zwłoki wymieniają się pomysłami i rozwiązaniami wykorzystując jego możliwości. Internet stał się platformą infrastrukturalną dla środowiska człowiek-maszyna do rozwiązywania problemów. Służy jako infrastruktura komunikacyjna E-mail, sieci, wyszukiwarki, Telefonia internetowa(telefonia IP) i inne usługi internetowe wykorzystywane w informatyzacji edukacji, nauki, ekonomii, administracji publicznej i innych działalności. Usługi elektroniczne stworzone na bazie Internetu umożliwiły skuteczne funkcjonowanie różnych komercyjnych i niekomercyjnych podmiotów internetowych: sklepów internetowych, sieci społecznościowych [Facebook (Facebook), VKontakte, Twitter (Twitter) itp.], wyszukiwarka silniki [Google (Google), Yandex (Yandex) i inne], encyklopedyczne zasoby internetowe [Wikipedia (Wikipedia), Webopedia itp.], biblioteki elektroniczne [Światowa Biblioteka Cyfrowa (Światowa Biblioteka Cyfrowa), Elektroniczna biblioteka naukowa eLibrary itp.] , korporacyjne i rządowe portale informacyjne itd.

Od 2000 roku intensywnie rośnie liczba rozwiązań internetowych – „inteligentny dom” (Smart House), „inteligentny system zasilania” (Smart Grid) itp. Pomyślnie rozwijają się rozwiązania M2M (M2M - Machine-to-Machine) oparte na technologiach informacyjnych interakcji maszyna-maszyna i przeznaczone do monitorowania czujników temperatury, liczników energii elektrycznej, wodomierzy itp.; śledzenie lokalizacji poruszających się obiektów w oparciu o systemy GLONASS i GPS (patrz. Satelitarny system pozycjonowania); kontrola dostępu do chronionych obiektów itp.

Oficjalna rejestracja informatyki w ZSRR. Informatyka została oficjalnie sformalizowana w ZSRR w 1983 roku, kiedy w ramach Akademii Nauk ZSRR utworzono Wydział Informatyki, Inżynierii Komputerowej i Automatyki. W jej skład weszły powstały w tym samym roku Instytut Problemów Informatyki Akademii Nauk ZSRR, Instytut Matematyki Stosowanej Akademii Nauk ZSRR, Centrum Informatyczne Akademii Nauk ZSRR, Instytut Przesyłu Informacji Problemy Akademii Nauk ZSRR i szeregu innych instytutów. W pierwszym etapie za główne uznano badania w zakresie sprzętu i oprogramowania do masowych obliczeń i systemów na nich opartych. Uzyskane wyniki miały stać się podstawą do stworzenia rodziny domowych komputerów osobistych (PC) i ich zastosowania do informatyzacji działalności naukowej, edukacyjnej i innych istotnych działań.

Problemy i perspektywy

Metodyczne wsparcie budowy osobistego s-środowiska. W najbliższych latach jednym z tematycznych obszarów wsparcia metodologicznego poprawy środowiska s będzie tworzenie spersonalizowanych systemów rozwiązywania problemów, których sprzęt jest umieszczany w sprzęcie użytkownika. Prędkości zaawansowane technologieŁączność bezprzewodowa jest już wystarczająca do rozwiązywania wielu problemów opartych na usługach internetowych. Oczekuje się, że do 2025 r. szybkość i rozpowszechnienie technologii komunikacji bezprzewodowej osiągną poziom, na którym część dzisiejszych interfejsów przewodowych zostanie zastąpiona interfejsami bezprzewodowymi. Obniżenie cen usług internetowych przyczyni się również do promocji technologii personalizacji s-środowiska użytkownika. Faktyczne problemy związane z personalizacją środowiska s to: tworzenie bardziej zaawansowanych systemów symbolicznych i kodowych; sprzętowo-programowa konwersja komunikatów dźwiękowych i dotykowych wysyłanych przez osobę na grafikę, reprezentowaną przez kompozycję tekstu, hipertekstu, znaków specjalnych i obrazów; udoskonalenie technologiczne i ujednolicenie interfejsów bezprzewodowych [przede wszystkim interfejsów wideo (wyjście do wyboru użytkownika: na specjalnych okularach, ekranach monitorów, telewizorze lub innym urządzeniu wyjściowym wideo)].

Wsparcie metodologiczne budowania osobistego s-środowiska powinno opierać się na wynikach badań z zakresu sztucznej inteligencji, których celem jest zbudowanie nie maszynowego symulatora ludzkiej inteligencji, ale inteligentnego partnera sterowanego przez człowieka. Rozwój technologii budowania osobistego s-środowiska obejmuje doskonalenie metodologii nauczania na odległość, interakcji itp.

Lista artykułów

1. Pomiar informacji – podejście alfabetyczne

2. Pomiar informacji – sensowne podejście

3. Procesy informacyjne

4. Informacje

5. Cybernetyka

6. Kodowanie informacji

7. Przetwarzanie informacji

8. Przekazywanie informacji

9. Reprezentacja liczb

10. Systemy liczbowe

11. Przechowywanie informacji

Głównymi przedmiotami badań nauki o informatyce są Informacja I procesy informacyjne. Informatyka jako samodzielna nauka powstała w połowie XX wieku, ale naukowe zainteresowanie informacją i badaniami w tej dziedzinie pojawiło się wcześniej.

Na początku XX wieku aktywnie rozwijały się techniczne środki komunikacji (telefon, telegraf, radio).

W związku z tym pojawia się kierunek naukowy „Teoria komunikacji”. Jej rozwój dał początek teorii kodowania i teorii informacji, której założycielem był amerykański naukowiec C. Shannon. Teoria informacji rozwiązała problem pomiary

Informacja transmitowane przez kanały komunikacyjne. Istnieją dwa podejścia do pomiaru informacji: znaczący I alfabetyczny.

Najważniejszym zadaniem stawianym przez teorię komunikacji jest walka z utratą informacji w kanałach transmisji danych. W trakcie rozwiązywania tego problemu powstała teoria kodowanie , w ramach którego wynaleziono metody przedstawiania informacji umożliwiające przekazanie treści wiadomości adresatowi bez zniekształceń, nawet w przypadku ubytków w przesyłanym kodzie. Te wyniki naukowe mają ogromne znaczenie nawet dzisiaj, kiedy ilość informacji przepływających w technicznych kanałach komunikacyjnych wzrosła o wiele rzędów wielkości.

Prekursorem współczesnej informatyki była nauka „Cybernetyka”, założona przez prace N. Wienera na przełomie lat czterdziestych i pięćdziesiątych. W cybernetyce nastąpiło pogłębienie pojęcia informacji, określono miejsce informacji w systemach sterowania w organizmach żywych, w systemach społecznych i technicznych. Cybernetyka zbadała zasady kontroli programów. Powstająca równocześnie z pojawieniem się pierwszych komputerów cybernetyka położyła podwaliny naukowe zarówno pod ich konstruktywny rozwój, jak i liczne zastosowania.

EVM (komputer) - automatyczne urządzenie przeznaczone do rozwiązywania problemów informacyjnych poprzez wdrażanie procesy informacyjne : przechowywanie, przetwarzanie I przekazywanie informacji. Opis podstawowych zasad i schematów procesów informacyjnych nawiązuje również do teoretycznych podstaw informatyki.

Komputer nie pracuje z treścią informacji, którą tylko osoba może odbierać, ale z danymi reprezentującymi informacje. Dlatego najważniejszym zadaniem dla technologii komputerowej jest: prezentacja informacji w postaci danych nadających się do ich przetwarzania. Dane i programy są zakodowane w forma binarna. Przetwarzanie dowolnego typu danych w komputerze sprowadza się do obliczeń na liczbach binarnych. Dlatego technologia komputerowa jest również nazywana cyfrową. Pojęcie systemów liczbowych, około reprezentacja liczb w komputerze należą do podstawowych pojęć informatyki.

Pojęcie „języka” pochodzi z językoznawstwa. Język - ten system symbolicznej reprezentacji informacji służących do jej przechowywania i przesyłania. Pojęcie języka jest jednym z podstawowe koncepcje informatyka, ponieważ zarówno dane, jak i programy w komputerze są reprezentowane jako struktury symboliczne. Język komunikacji między komputerem a człowiekiem coraz bardziej zbliża się do form języka naturalnego.

DO podstawy informatyka odwołuje się do teorii algorytmów. pojęcie algorytm wprowadzony w artykule „Przetwarzanie informacji”. Ten temat został szczegółowo omówiony w piątej części encyklopedii.

1. Pomiar informacji. Podejście alfabetyczne

Do pomiaru stosuje się podejście alfabetyczne ilość informacji w tekście reprezentowanym jako ciąg znaków jakiegoś alfabetu. To podejście nie jest związane z treścią tekstu. Ilość informacji w tym przypadku nazywa się informacyjna objętość tekstu, który jest proporcjonalny do rozmiaru tekstu - liczba znaków, z których składa się tekst. Czasami takie podejście do pomiaru informacji nazywa się podejściem wolumetrycznym.

Każdy znak tekstu zawiera pewną ilość informacji. Jest on nazywany symbol informacja waga. Dlatego objętość informacyjna tekstu jest równa sumie wag informacyjnych wszystkich znaków, które składają się na tekst.

![]()

Tutaj zakłada się, że tekst jest kolejnym ciągiem ponumerowanych znaków. W formule (1) i 1 oznacza wagę informacyjną pierwszego znaku tekstu, i 2 - waga informacyjna drugiego znaku tekstu itp.; K- rozmiar tekstu, tj. łączna liczba znaków w tekście.

Cały zestaw różnych znaków używanych do pisania tekstów nazywa się alfabetycznie. Wielkość alfabetu to liczba całkowita zwana moc alfabetu. Należy pamiętać, że alfabet zawiera nie tylko litery określonego języka, ale wszystkie inne znaki, które można użyć w tekście: cyfry, znaki interpunkcyjne, różne nawiasy, spacje itp.

Wyznaczanie wag informacyjnych symboli może odbywać się w dwóch przybliżeniach:

1) przy założeniu równego prawdopodobieństwa (tej samej częstości występowania) dowolnego znaku w tekście;

2) uwzględnienie różnego prawdopodobieństwa (różnej częstotliwości występowania) różnych znaków w tekście.

Aproksymacja równego prawdopodobieństwa znaków w tekście

Jeżeli przyjmiemy, że wszystkie znaki alfabetu w dowolnym tekście pojawiają się z tą samą częstotliwością, to waga informacyjna wszystkich znaków będzie taka sama. Zostawiać n- potęga alfabetu. Wtedy proporcja dowolnego znaku w tekście wynosi 1/ n część tekstu. Zgodnie z definicją prawdopodobieństwa (por. „Pomiar informacji. Podejście do treści”) wartość ta jest równa prawdopodobieństwu wystąpienia znaku w każdej pozycji tekstu:

Zgodnie z formułą K. Shannona (zob. „Pomiar informacji. Podejście do treści”), ilość informacji zawartych w symbolu oblicza się w następujący sposób:

i = log2(1/ P) = log2 n(fragment) (2)

Dlatego waga informacyjna symbolu ( i) i moc alfabetu ( n) są połączone formułą Hartleya (patrz „ Pomiar informacji. Podejście do treści” )

2 i = N.

Znajomość wagi informacyjnej jednego znaku ( i) oraz rozmiar tekstu wyrażony liczbą znaków ( K), objętość informacyjną tekstu można obliczyć za pomocą wzoru:

I= K · i (3)

Formuła ta jest szczególną wersją formuły (1) w przypadku, gdy wszystkie symbole mają taką samą wagę informacyjną.

Ze wzoru (2) wynika, że w n= 2 (alfabet binarny) waga informacji jednego znaku wynosi 1 bit.

Z punktu widzenia alfabetycznego podejścia do pomiaru informacji 1 bit -jest informacyjną wagą znaku z alfabetu binarnego.

Większą jednostką informacji jest bajt.

1 bajt -jest wagą informacyjną znaku z alfabetu o potędze 256.

Od 256 \u003d 2 8 połączenie między bitem a bajtem wynika ze wzoru Hartleya:

2 i = 256 = 2 8

Stąd: i= 8 bitów = 1 bajt

Do reprezentacji tekstów przechowywanych i przetwarzanych w komputerze najczęściej używany jest alfabet o pojemności 256 znaków. W konsekwencji,

1 znak takiego tekstu "waży" 1 bajt.

Oprócz bitu i bajtu do pomiaru informacji używane są również większe jednostki:

1 KB (kilobajt) = 2 10 bajtów = 1024 bajty,

1 MB (megabajt) = 2 10 KB = 1024 KB,

1 GB (gigabajt) = 2 10 MB = 1024 MB.

Aproksymacja różnych prawdopodobieństw występowania znaków w tekście

To przybliżenie uwzględnia fakt, że w tekście rzeczywistym różne znaki występują z różną częstotliwością. Wynika z tego, że prawdopodobieństwa pojawienia się różnych znaków w określonym miejscu tekstu są różne, a co za tym idzie ich wagi informacyjne są różne.

Analiza statystyczna tekstów rosyjskich pokazuje, że częstotliwość litery „o” wynosi 0,09. Oznacza to, że na każde 100 znaków litera „o” występuje średnio 9 razy. Ta sama liczba wskazuje na prawdopodobieństwo pojawienia się litery „o” w określonej pozycji tekstu: P o = 0,09. Wynika z tego, że waga informacyjna litery „o” w tekście rosyjskim jest równa:

Najrzadszą literą w tekstach jest litera „f”. Jego częstotliwość wynosi 0,002. Stąd:

Wynika z tego jakościowy wniosek: waga informacyjna rzadkich liter jest większa niż waga często występujących liter.

Jak obliczyć objętość informacyjną tekstu, biorąc pod uwagę różne wagi informacyjne symboli alfabetu? Odbywa się to według następującego wzoru:

Tutaj n- wielkość (moc) alfabetu; nj- ilość powtórzeń numeru znaku J w tekście; ja ja- waga informacyjna numeru symbolu J.

Podejście alfabetyczne na kursie informatyki u podstaw szkoły

W toku informatyki w szkole głównej uczniowie zapoznają się z podejście alfabetyczne Do pomiaru informacji najczęściej dochodzi w kontekście komputerowej reprezentacji informacji. Główne zdanie brzmi tak:

Ilość informacji jest mierzona rozmiarem kodu binarnego, za pomocą którego ta informacja jest reprezentowana.

Ponieważ każdy rodzaj informacji jest reprezentowany w pamięci komputera w postaci kodu binarnego, definicja ta jest uniwersalna. Dotyczy informacji symbolicznych, liczbowych, graficznych i dźwiękowych.

Jeden znak ( wypisać)kod binarny przenosi 1trochę informacji.

Wyjaśniając sposób pomiaru objętości informacyjnej tekstu na kursie informatyki podstawowej, zagadnienie to ujawnia się poprzez następującą sekwencję pojęć: alfabet-rozmiar kodu binarnego znaku-objętość informacyjna tekstu.

Logika rozumowania rozwija się od konkretnych przykładów do uzyskania ogólnej reguły. Niech w alfabecie jakiegoś języka będą tylko 4 znaki. Oznaczmy je: , , , . Symbole te można zakodować za pomocą czterech dwucyfrowych kodów binarnych: - 00, - 01, - 10, - 11. W tym przypadku stosowane są wszystkie opcje rozmieszczenia dwóch znaków po dwa, których liczba wynosi 2 2 = 4. A Alfabet czteroznakowy jest równy dwóm bitom.

Kolejnym szczególnym przypadkiem jest 8-znakowy alfabet, którego każdy znak może być zakodowany 3-bitowym kodem binarnym, ponieważ liczba rozmieszczeń dwóch znaków w grupach po 3 wynosi 2 3 = 8. W związku z tym waga informacji znak z 8-znakowego alfabetu to 3 bity. Itp.

Uogólniając poszczególne przykłady, otrzymujemy ogólną zasadę: używając b- bitowy kod binarny, można zakodować alfabet składający się z n = 2 b- symbole.

Przykład 1. Do napisania tekstu używane są tylko małe litery alfabetu rosyjskiego, a do oddzielania słów używana jest „spacja”. Jaka jest objętość informacyjna tekstu składającego się z 2000 znaków (jedna strona drukowana)?

Rozwiązanie. W alfabecie rosyjskim są 33 litery. Zmniejszając go o dwie litery (na przykład „ё” i „й”) i wprowadzając znak spacji, otrzymujemy bardzo wygodną liczbę znaków - 32. Korzystając z przybliżenia równego prawdopodobieństwa znaków, piszemy formułę Hartleya:

2i= 32 = 2 5

Stąd: i= 5 bitów - waga informacyjna każdego znaku alfabetu rosyjskiego. Wtedy objętość informacyjna całego tekstu jest równa:

I = 2000 5 = 10 000 fragment

Przykład 2. Oblicz objętość informacyjną tekstu o wielkości 2000 znaków, w zapisie którego używany jest alfabet komputerowej reprezentacji tekstów o pojemności 256.

Rozwiązanie. W tym alfabecie waga informacji każdego znaku wynosi 1 bajt (8 bitów). Dlatego objętość informacyjna tekstu wynosi 2000 bajtów.

W praktycznych zadaniach na ten temat ważne jest rozwijanie umiejętności uczniów w zakresie przeliczania ilości informacji na różne jednostki: bity - bajty - kilobajty - megabajty - gigabajty. Jeśli przeliczymy objętość informacyjną tekstu z przykładu 2 na kilobajty, otrzymamy:

2000 bajtów = 2000/1024 1,9531 KB

Przykład 3. Objętość wiadomości zawierającej 2048 znaków wynosiła 1/512 megabajta. Jaka jest wielkość alfabetu, za pomocą którego napisana jest wiadomość?

Rozwiązanie. Przetłumaczmy ilość informacji w wiadomości z megabajtów na bity. Aby to zrobić, mnożymy tę wartość dwa razy przez 1024 (otrzymujemy bajty) i raz przez 8:

I = 1/512 1024 1024 8 = 16384 bity.

Ponieważ ta ilość informacji zawiera 1024 znaki ( DO), wtedy jeden znak odpowiada za:

ja = i/K= 16 384/1024 = 16 bitów.

Wynika z tego, że wielkość (potęga) użytego alfabetu wynosi 2 16 = 65 536 znaków.

Podejście wolumetryczne w toku informatyki w liceum

Studiując informatykę w klasach 10-11 na podstawowym poziomie kształcenia ogólnego, uczniowie mogą pozostawić swoją wiedzę w zakresie wolumetrycznego podejścia do pomiaru informacji na takim samym poziomie jak opisany powyżej, tj. w kontekście ilości binarnego kodu komputerowego.

Studiując informatykę na poziomie profilu, podejście wolumetryczne należy rozpatrywać z bardziej ogólnych pozycji matematycznych, wykorzystując pomysły dotyczące częstotliwości znaków w tekście, prawdopodobieństw i relacji prawdopodobieństw z wagami informacyjnymi symboli.

Znajomość tych zagadnień jest ważna dla głębszego zrozumienia różnicy w stosowaniu jednolitego i niejednolitego kodowania binarnego (zob. „Kodowanie informacji”), aby zrozumieć niektóre techniki kompresji danych (zob. "Kompresja danych") i algorytmy kryptograficzne (patrz „Kryptografia” ).

Przykład 4. W alfabecie plemienia MUMU są tylko 4 litery (A, U, M, K), jeden znak interpunkcyjny (kropka) i spacja służy do oddzielania wyrazów. Obliczono, że popularna powieść „Mumuka” zawiera tylko 10 000 znaków, z czego: litery A – 4000, litery U – 1000, litery M – 2000, litery K – 1500, kropki – 500, spacje – 1000. Ile informacji zawiera książka?

Rozwiązanie. Ponieważ objętość książki jest dość duża, można przyjąć, że częstość występowania w tekście każdego z wyliczonych z niej symboli alfabetu jest typowa dla każdego tekstu w języku MUMU. Obliczmy częstotliwość występowania każdego znaku w całym tekście książki (czyli prawdopodobieństwo) oraz wagi informacyjne znaków

Całkowita ilość informacji w księdze jest obliczana jako suma iloczynów wagi informacji każdego symbolu i liczby powtórzeń tego symbolu w księdze:

2. Pomiar informacji. Podejście do treści

1) osoba otrzymuje wiadomość o jakimś zdarzeniu; póki wiadomo z góry niepewność wiedzy osoba o oczekiwanym zdarzeniu. Niepewność wiedzy może być wyrażona albo liczbą możliwych wariantów zdarzenia, albo prawdopodobieństwem oczekiwanych wariantów zdarzenia;

2) w wyniku odebrania wiadomości usuwa się niepewność wiedzy: z pewnej możliwej liczby opcji wybrano jedną;

3) formuła oblicza ilość informacji w odebranej wiadomości wyrażoną w bitach.

Formuła używana do obliczenia ilości informacji zależy od sytuacji, które mogą być dwie:

1. Wszystkie możliwe warianty zdarzenia są jednakowo prawdopodobne. Ich liczba jest skończona i równa n.

2. Prawdopodobieństwo ( P) możliwe warianty imprezy są różne i są z góry znane:

(pi ), i = 1.. n. Tutaj jest nadal n- ilość możliwych wariantów imprezy.

Niesamowite wydarzenia. Jeśli jest oznaczony przez i ilość informacji w wiadomości, że jeden z n zdarzenia prawdopodobne, to ilości i I n są połączone formułą Hartleya:

2i=n (1)

Wartość i mierzone w bitach. Z tego wynika wniosek:

1 bit to ilość informacji w wiadomości o jednym z dwóch równie prawdopodobnych zdarzeń.

Wzór Hartleya jest równaniem wykładniczym. Jeśli i jest wielkością nieznaną, to rozwiązaniem równania (1) będzie:

i = log 2 n (2)

Wzory (1) i (2) są identyczne. Czasami w literaturze formuła Hartleya nazywana jest (2).

Przykład 1. Ile informacji zawiera komunikat, że dama pik została pobrana z talii kart?

W talii są 32 karty. W przetasowanej talii utrata jakiejkolwiek karty jest równie prawdopodobnym wydarzeniem. Jeśli i- ilość informacji w komunikacie, że dana karta padła (np. dama pik), a następnie z równania Hartleya:

2 i = 32 = 2 5

Stąd: i= 5 bitów.

Przykład 2. Ile informacji zawiera wiadomość o rzucie twarzą z cyfrą 3 na kostce sześciościennej?

Traktując utratę jakiejkolwiek twarzy jako zdarzenie równie prawdopodobne, piszemy wzór Hartleya: 2 i= 6. Stąd: i= log 2 6 = 2,58496 fragment.

Zdarzenia nieprawdopodobne (podejście probabilistyczne)

Jeśli prawdopodobieństwo jakiegoś zdarzenia wynosi P, ale i(bit) to ilość informacji w komunikacie, że to zdarzenie miało miejsce, wtedy wartości te są powiązane wzorem:

2 i = 1/P (3)

Rozwiązywanie równania wykładniczego (3) względem i, otrzymujemy:

i = log 2 (1/ P) (4)

Formuła (4) została zaproponowana przez K. Shannona, dlatego nazywa się ją formułą Shannona.

Omówienie relacji między ilością informacji w komunikacie a jego treścią może odbywać się na różnych poziomach głębi.

Podejście jakościowe

Podejście jakościowe, które można wykorzystać na poziomie propedeutyki przedmiotu informatyka podstawowa (klasy 5–7) lub kursu podstawowego (klasy 8–9).

Na tym poziomie studiów omawiany jest następujący łańcuch pojęć: informacja - przekaz - informacyjność przekazu.